简介

气候变化可以说是我们这个时代最紧迫的挑战。为了解企业界如何适应这一变化,从投资者到监管机构的利益相关者都严重依赖企业可持续发展报告。这些文件篇幅巨大、性质定性且内容复杂,往往将有关气候风险和战略的关键数据隐藏在密集的文本叙述中。

为了处理海量信息,科技界转向了 检索增强生成 (Retrieval Augmented Generation, RAG) 。 RAG 系统利用人工智能搜索文档,找到相关段落,并利用它们生成特定问题的答案。这听起来像是完美的解决方案。然而,这里有一个问题: 我们实际上并不清楚这些系统在气候领域的特定 检索 任务中表现如何。

如果 RAG 系统未能找到正确的段落 (检索) ,AI 就无法生成正确的答案 (生成) ,从而导致幻觉。虽然我们要么检查生成的文本是否通顺,但一直缺乏一个可靠的基准来验证 AI 是否在第一时间找到了正确的证据。

这就引出了 ClimRetrieve 。 在最近的一篇论文中,研究人员引入了一个新的基准数据集,旨在模拟专业可持续发展分析师的工作流程。通过创建一个包含问题和经过验证来源的黄金标准数据集,他们为理解——并改进——AI 如何处理复杂气候数据打开了大门。

背景: 气候 NLP 的复杂性

在深入研究数据集之前,了解这为何困难至关重要。气候领域的自然语言处理 (NLP) 历来专注于分类——例如,检测“漂绿”行为或将声明分类为“环境”或“社会”类。

然而,现代分析需要的不仅仅是分类;它需要复杂的推理。考虑这个问题: “公司是否有特定的流程来识别因气候变化产生的风险?”

要回答这个问题,分析师 (或 AI) 不能简单地查找关键字“风险”。他们必须理解“物理风险”、“转型风险”、“适应”和“治理”等概念。他们需要区分关于爱护地球的一般性陈述与具体的、可操作的流程。

RAG 系统试图通过将问题和文档文本都嵌入为数学向量来解决这个问题。如果问题的向量与段落的向量“接近”,系统就会假设该段落包含答案。但这种标准方法能否捕捉到气候专家知识的细微差别呢?这正是 ClimRetrieve 旨在测试的内容。

构建 ClimRetrieve 数据集

这项研究的核心贡献是创建了一个模仿人类专家行为的数据集。研究人员并没有简单地抓取数据;他们采用了一套严格的、由专家主导的流程。

分析师工作流程

该数据集围绕 30 份可持续发展报告和 16 个关于气候变化适应和韧性的详细问题构建。这些问题不是随机的;它们受到旨在将金融与适应目标对齐的框架的启发。

创建过程涉及三位专家标注员 (具有气候科学背景的研究人员) ,他们遵循特定的工作流程以确保高质量的数据。

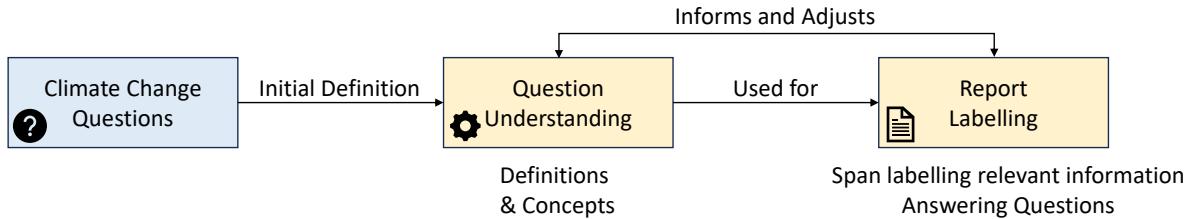

如图 2 所示,该过程是迭代的:

- 问题理解: 在查看报告之前,专家们定义了问题和基本概念。

- 报告标注: 他们阅读报告,寻找回答问题的具体文本跨度。

- 细化: 根据在真实报告中发现的内容,不断调整定义。

这一过程产生了一个包含超过 8,500 个已标注段落 的数据集。每个条目包含文档、问题、特定文本来源以及——至关重要的——相关性评分。

相关性并非生而平等

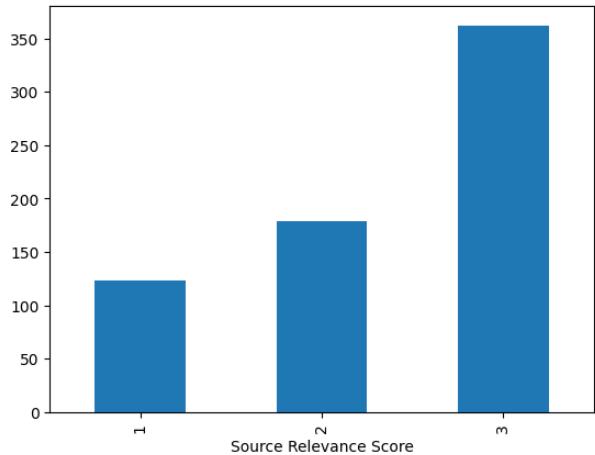

在现实世界中,答案并不总是简单的“是”或“否”。有时一个段落至关重要 (相关性 3) ,有时它只在某种程度上相关 (相关性 1) 。

图 F.1 展示了最终数据集中这些标签的分布。研究人员发现,专家确定的大多数来源都高度相关 (得分为 3) 。这反映了分析师的心态: 他们正在寻找尽可能最好的证据来支持他们的结论。

最终结果是一个“报告级数据集”。对于报告中的每一段,我们现在都知道它是否与特定的气候问题相关。这有效地创建了一个我们可以用来测试 AI 模型的“真值” (ground truth) 。

实验: AI 能像专家一样搜索吗?

有了这个数据集,研究人员提出了一个关键问题: 我们如何将专家知识整合到检索过程中?

在标准的 RAG 设置中,系统接收用户的问题,将其转换为向量,并在文档中搜索相似的向量。但气候问题是“知识密集型”的。简单的语义搜索可能会错过专家自然会建立的深层概念联系。

研究人员设计了一个实验,使用“嵌入模型” (将文本转换为数字的 AI) 测试不同的搜索策略。他们比较了四种主要的寻找答案的方法:

- 仅问题: 标准方法。仅对问题进行嵌入。

- 定义与概念: 用人类标注员编写的定义替换问题。

- 通用解释: 要求 GPT-4 编写一段关于问题含义的解释,并使用该解释进行搜索。

- 专家知情解释: 最先进的方法。在这里,他们向 GPT-4 提供了相关段落的 实际示例 (来自训练集) ,并要求它基于这些示例编写搜索查询。

设计完美的提示词

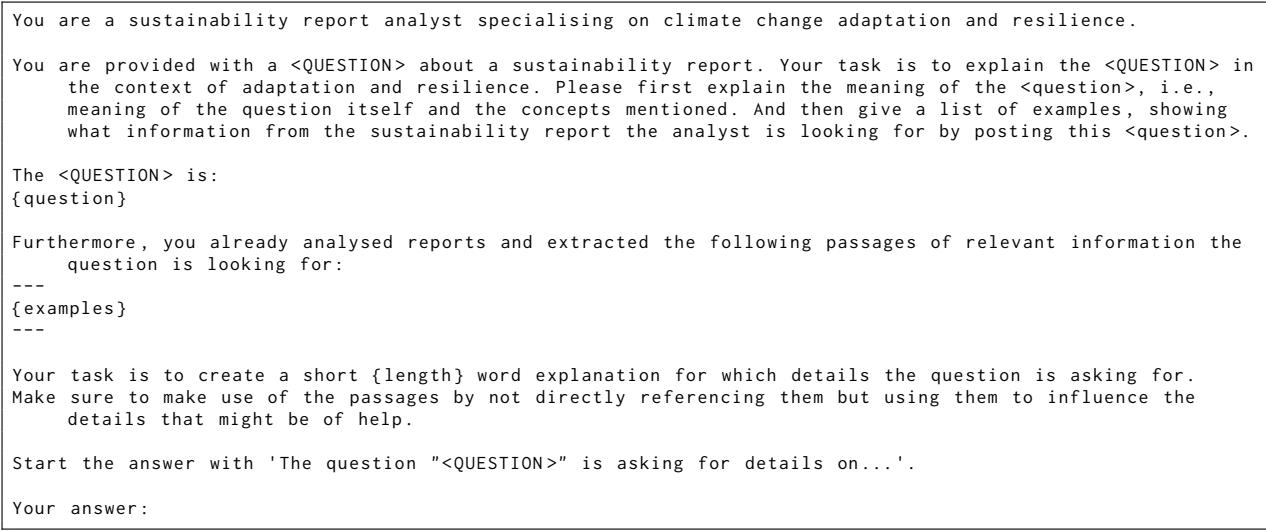

为了生成这些“专家知情解释”,研究人员使用了特定的提示词,在查询生成过程中透露了一些“黄金标准”知识,以模拟专家的直觉。

图 H.5 展示了他们是如何提示模型的。他们提供问题和相关段落的示例,然后要求模型解释分析师正在寻找哪些细节。

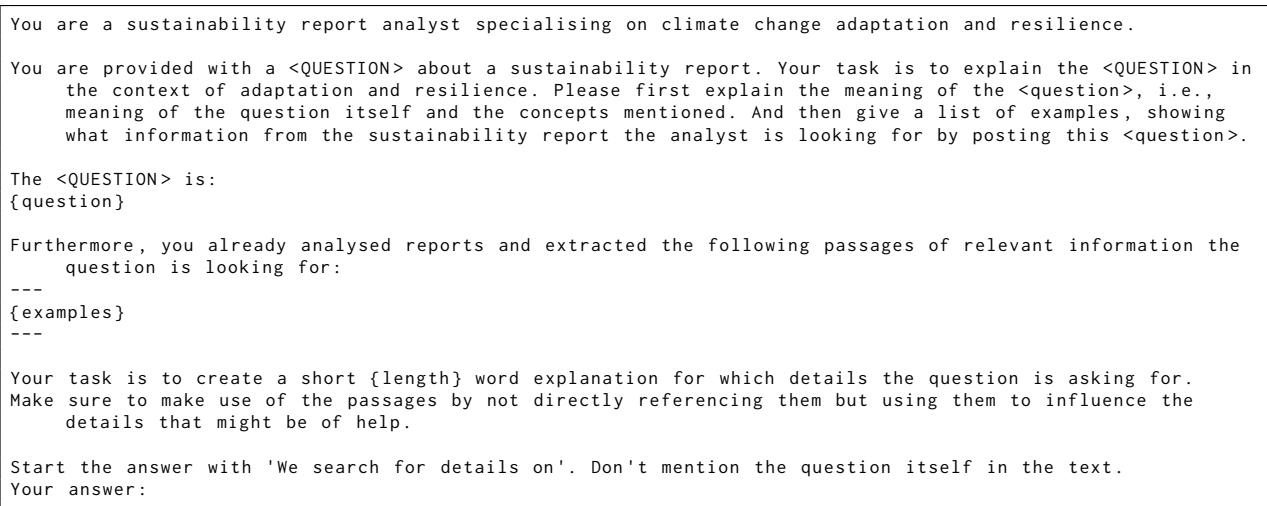

他们还测试了一种变体,即在搜索查询中明确 排除 问题文本,仅依赖解释。

如图 H.6 所示,该提示强制搜索完全集中在所需的 概念 和 细节 上,而不是原始问题的措辞。

实验与结果

为了评估哪种方法效果最好,研究人员使用了标准的信息检索指标: Recall@K (召回率@K) 和 Precision@K (精确率@K) 。

Recall@K 衡量系统在前 K 个结果 (例如,前 5 个或前 10 个段落) 中找到了多少相关段落。

Precision@K 衡量检索到的段落中有多少实际上是相关的。

发现

结果出人意料,凸显了当前“开箱即用”AI 模型的局限性。

1. 人工定义没有帮助。 反直觉的是,用人类标注员编写的定义替换问题实际上 降低 了性能 (与仅使用问题相比) 。研究人员推测,这是因为人类笔记是为了辅助人类理解而写的,并不是为了针对向量搜索算法进行优化。

2. 专家知情解释更胜一筹。 实验表明,使用“专家知情解释”——由看过正确答案示例的 LLM 生成的查询——显著优于其他方法。

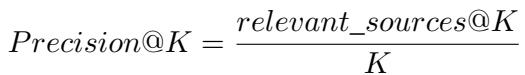

图 3 展示了使用 text-embedding-3-large 模型的结果。X 轴代表不同的策略 (question、generic、inf_3、inf_all) 。

- 召回率 (上排) : 注意上升趋势。

inf_all策略 (使用由所有可用示例提供信息的解释) 始终比简单的question策略检索到更多相关来源。 - 精确率 (下排) : 随着我们检索更多文档 (更高的 K) ,精确率往往会下降,这是意料之中的。然而,专家知情策略仍然保持着竞争优势。

3. “无问题”策略。

也许最有趣的发现是,最佳性能通常来自于从搜索查询中 排除问题本身 (图表中的 noQ 线) 。通过仅使用所需内容的详细 解释 (概念、特定数据点) 进行搜索,嵌入模型较少受到问题措辞的干扰,而更多地关注答案的语义内容。

结果的稳健性

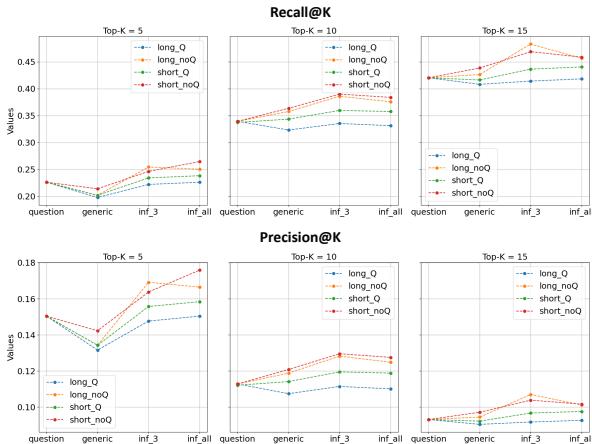

研究人员在多个嵌入模型 (包括 text-embedding-3-small) 上验证了这些发现。

如图 L.10 所示,即使使用较小、功能较弱的模型,趋势依然存在: 使用专家级解释 (图表右侧) 来辅助搜索,比单独使用问题能产生更好的召回率。

结论与启示

ClimRetrieve 论文强调了当前在可持续发展领域部署 AI 存在的一个关键差距。虽然 RAG 系统很强大,但它们不是魔法。在像气候变化这样的知识密集型领域,简单地将问题插入标准的嵌入模型通常不足以捕捉准确报告所需的细微差别。

这项工作的主要启示是:

- 领域专业知识至关重要: 标准的“最先进”嵌入模型很难依靠自身反映领域专业知识。

- 面向检索的提示工程: 我们可以通过在执行搜索之前将用户问题转化为详细的、基于示例的解释来提高性能。

- 数据集: ClimRetrieve 为研究人员提供了必要的基准,以测试和改进未来专门用于气候披露的 RAG 系统。

对于学生和未来的研究人员来说,这篇论文提醒我们,“更好的 AI”并不总是意味着更大的模型;有时,它意味着更好的数据以及对试图解决的领域有更深刻的理解。通过模拟人类专家的工作流程,我们可以构建不仅能阅读文字,还能真正理解其背后概念的系统。

](https://deep-paper.org/en/paper/2406.09818/images/cover.png)