引言

像 Llama-3 和 Mistral 这样的大语言模型 (LLM) 为了追求更大、更强的能力,引领了人工智能领域的惊人突破。然而,这种进步伴随着巨大的代价。随着这些模型的规模扩展到数十亿个参数,在资源受限的环境中部署它们变得越来越困难。由于内存和能源的限制,在消费级 GPU 上——更不用说移动设备了——运行一个 700 亿参数的模型通常是不切实际的。

为了解决这个问题,AI 社区转向了 模型压缩 。 两种最常见的技术是 量化 (降低数值的精度,例如从 16 位降到 4 位) 和 剪枝 (完全移除参数) 。虽然有效,但这些方法也有缺点。量化通常需要特定的硬件支持,而剪枝——尤其是移除整个层——是一个破坏性的过程。这就像试图通过撕掉随机章节来缩短一本书;你可能节省了空间,但面临着丢失剧情的风险。

但是,如果我们不扔掉这些层,而是将它们 合并 呢?

这正是这篇引人入胜的新论文的核心前提,论文题为 *“Pruning via Merging: Compressing LLMs via Manifold Alignment Based Layer Merging” (通过合并进行剪枝: 基于流形对齐层合并的 LLM 压缩) *。研究人员提出了一种名为 MKA (基于流形的知识对齐,Manifold-Based Knowledge Alignment) 的新方法。MKA 不是简单地删除冗余层,而是识别共享相似“知识”的层并将它们融合在一起。通过利用 流形学习 (Manifold Learning) 和 信息瓶颈 (Information Bottleneck, IB) 原理等先进概念,MKA 在极小的性能损失下实现了巨大的压缩比。

在这篇文章中,我们将逐步介绍 MKA 的工作原理,它为何优于传统剪枝,以及使其成为可能的数学原理。

背景: 巨人的冗余

要理解为什么我们能压缩这些模型,我们首先需要理解 过参数化 (Overparameterization) 的概念。

LLM 虽然是在数万亿个 token 上训练出来的,但它们的结构效率低得令人难以置信。研究表明,现代深度神经网络是极度过参数化的,这意味着它们的神经元和层数远远超过了解决其训练任务所严格需要的数量。

从数学上讲,这种冗余意味着对于具有参数 \(\theta\) 的给定模型,很可能存在一个更小的子集或稍微不同的配置 \(\theta'\),能够产生几乎相同的结果。

如上式所示,如果原始模型和修改后的模型之间的损失 (误差) 差异可以忽略不计 (\(\delta\)) ,则认为参数的子集是冗余的。

传统的 结构化剪枝 试图找到并移除这些冗余结构 (如整个层) 。然而,简单地移除一层会中断信息的流动。网络是被训练用于按顺序传递数据的;移除一个步骤会对系统造成“冲击”,通常需要重新训练来修复。

MKA 的作者提出了一个不同的问题: 模型是否在不同的层学习了相似的表示? 如果第 20 层和第 21 层做的事情几乎相同,我们不应该删除其中一个;我们应该在数学上将它们结合起来。

MKA 框架

基于流形的知识对齐 (MKA) 框架建立在两大支柱之上:

- 流形学习: 用于理解流经各层的数据的几何结构。

- 层合并: 使用信息论基于层的相似性来融合层。

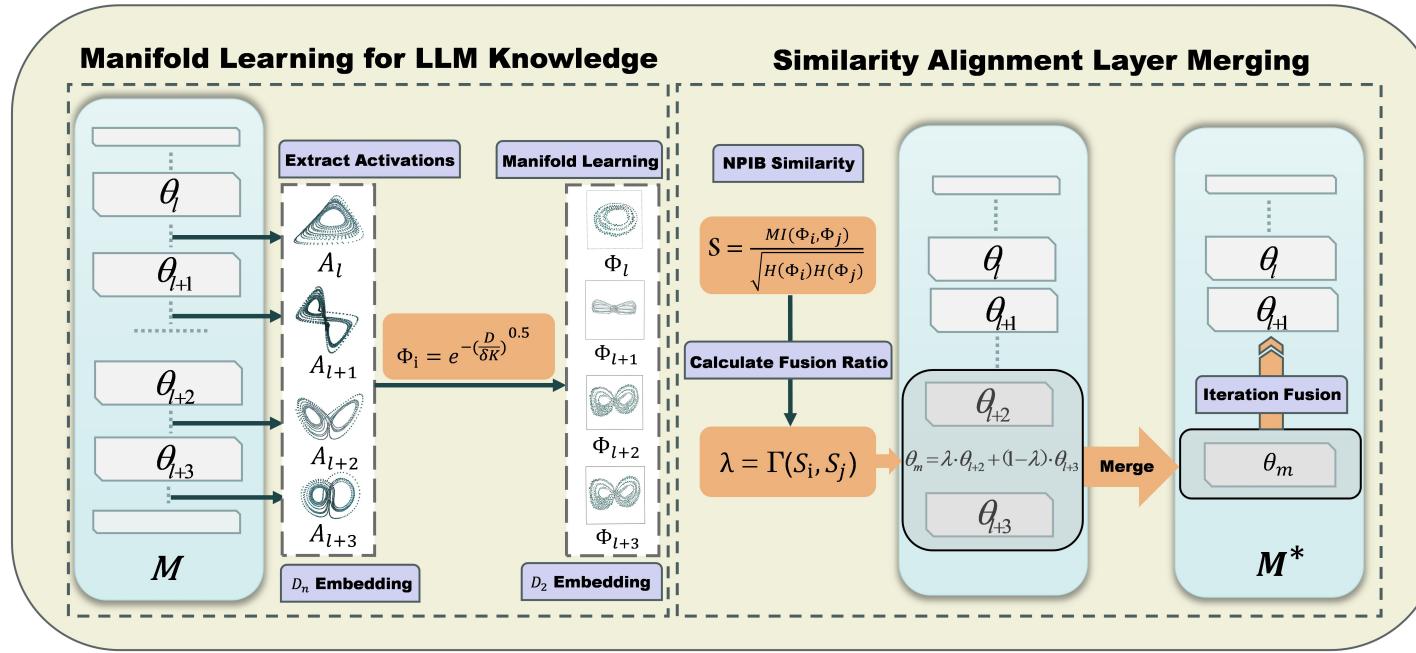

下方的图 1 提供了该架构的高级概览。

左侧展示了激活值的提取和“流形”的创建。右侧展示了相似性分析以及最终的层合并。让我们一步步来拆解这个过程。

第 1 步: 流形学习与扩散映射

原始层的激活值只是一个巨大的数字矩阵。直接通过查看权重或原始输出来比较两个层是充满噪声且通常不准确的,因为它们可能在略微不同的高维空间中表示相同的信息。

为了解决这个问题,作者依赖于 流形假设 (Manifold Hypothesis) 。 该假设认为,高维数据 (如 LLM 激活值) 实际上位于嵌入在该空间内的低维结构 (流形) 上。想象一根螺旋弹簧;它存在于 3D 空间中,但这部分数据本质上是一条卷曲起来的 1D 线条。

为了捕捉这种结构,MKA 使用了 扩散映射 (Diffusion Maps) 。

构建图

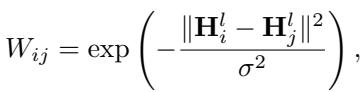

首先,对于特定层 \(l\),该方法从一组输入中提取激活值 \(H\)。它构建一个图,其中每个节点是一个激活向量,它们之间的连接由它们的相似程度决定。这种相似性是使用 高斯核 (Gaussian Kernel) 计算的:

这里,\(W_{ij}\) 代表两个激活向量之间的亲和力 (接近度) 。如果它们很近,该值接近 1;如果很远,接近 0。

扩散算子

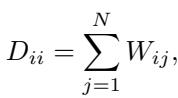

接下来,我们将这种关系归一化以创建一个概率矩阵。我们计算每个节点的“度” (其连接的总和) :

并用它来定义 扩散算子 (Diffusion Operator) \(P\):

这个算子 \(P\) 描述了数据上的“随机游走”。如果你站在一个数据点上并随机迈出一步,\(P\) 会告诉你可能会落在哪里。这有效地捕捉了数据流形的局部几何结构。

创建嵌入

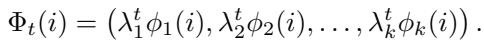

最后,为了获得该层 实际上 知道的内容的清晰、低维表示,该方法对这个算子执行谱分解 (特征分解) 。时刻 \(t\) 的 扩散映射 定义为:

这个向量 \(\Phi_t\) 是该层知识的压缩几何指纹。如果两个层产生相似的扩散映射,即使它们的原始权重看起来不同,它们也在以几何相似的方式处理信息。

第 2 步: 用互信息度量相似性

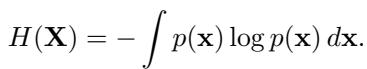

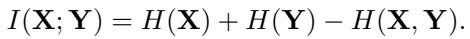

现在我们有了这些干净的流形嵌入 (层 \(l\) 的 \(\Psi^l\) 和层 \(m\) 的 \(\Psi^m\)) ,我们需要一个鲁棒的指标来比较它们。作者选择了 互信息 (Mutual Information, MI) 。

MI 衡量一个变量告诉我们关于另一个变量的多少信息。它是使用熵 (Entropy, \(H\)) 定义的:

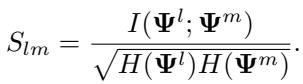

为了使其能够实际用于比较各层,作者使用了一个 归一化相似度分数 (Normalized Similarity Score, \(S_{lm}\)) 。 这缩放了互信息,使得网络不同部分的值具有可比性:

如果 \(S_{lm}\) 很高,意味着层 \(l\) 和层 \(m\) 是高度冗余的——它们“知道”同样的事情。这些就是我们要合并的候选层。

第 3 步: 通过信息瓶颈进行层合并

一旦识别出一对相似的层 (例如,第 31 层和第 32 层) ,我们将它们合并为单层。但我们不仅仅是取简单的平均值 (\(\frac{Layer A + Layer B}{2}\))。我们要保留最关键的信息。

作者采用了 信息瓶颈 (Information Bottleneck, IB) 原理。IB 的目标是找到输入 \(X\) 的压缩表示 \(T\),该表示尽可能多地保留关于目标 \(Y\) 的信息。

在层合并的背景下,该方法寻求一个合并后的表示 \(\Psi^c\),它保留了原始两层的共享信息,同时过滤掉噪声。合并被建模为一个由参数 \(\alpha\) 加权的线性组合:

关键部分是确定 \(\alpha\) (合并比例) 。虽然论文推导了一个复杂的导数来求最佳 \(\alpha\),但他们发现一种启发式近似方法既高效又有效。他们将 \(\alpha\) 设置为与相似度分数成正比:

最后,计算新合并层的权重 \(\theta_c\):

这产生了一个压缩模型,其中两个层在数学上变成了一个,理想情况下保留了二者的能力。

实验与结果

理论听起来很扎实,但在实践中效果如何?研究人员在几个流行的开源模型上测试了 MKA,包括 Llama-2 (7B, 13B)、Llama-3 (8B) 和 Mistral-7B。

MKA 对比传统剪枝

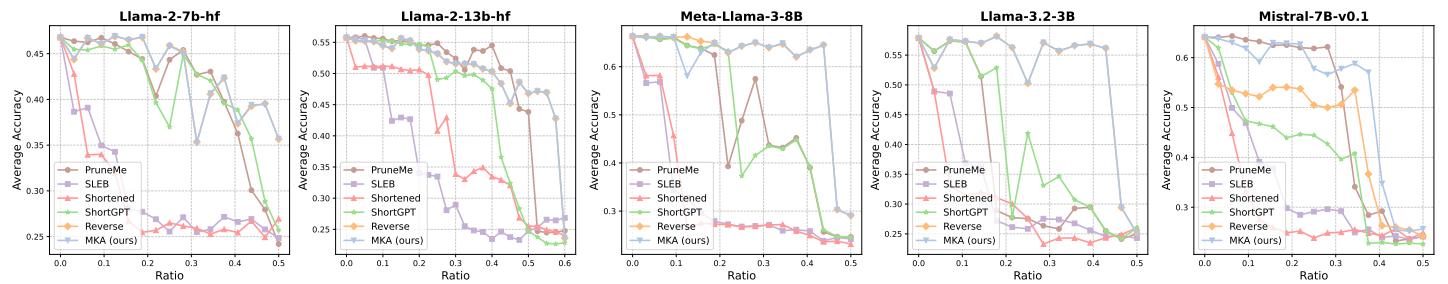

主要的对比对象是最先进的结构化剪枝方法,如 ShortGPT、SLEB 和 PruneMe。评估指标?在大规模 MMLU 基准测试上的准确率。

上面的图表讲述了一个令人信服的故事。X 轴代表 剪枝比例 (移除了多少模型) ,Y 轴是准确率。

- 看蓝线 (MKA) : 随着压缩比的增加,它始终高于其他方法 (绿色、橙色、红色) 。

- 稳定性: 当剪枝超过 20-30% 时,其他方法的性能会出现急剧“崩溃”,而 MKA 即使在压缩比接近 40-50% 时仍能保持可观的准确率。

- Llama-2-13B: MKA 在此模型上实现了近 58% 的压缩比 , 同时保持性能相对稳定,这是一个巨大的尺寸缩减。

结合合并与量化

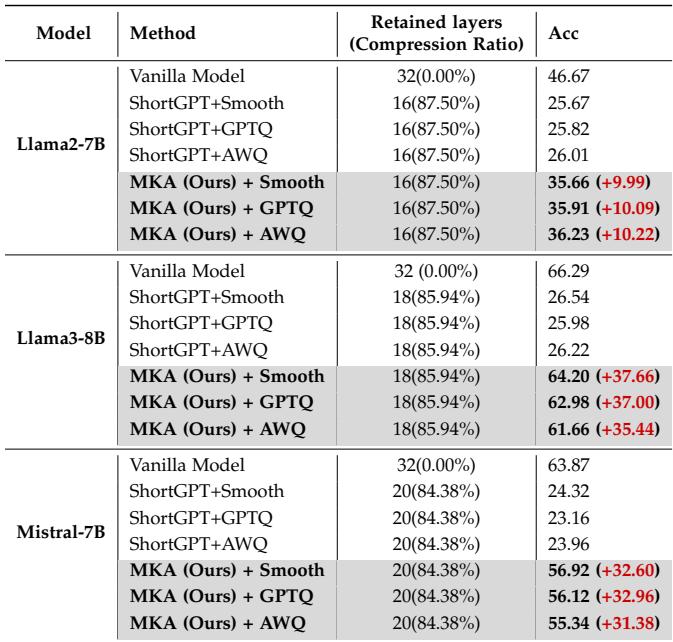

最令人兴奋的发现之一是,MKA 与量化并不互斥。你可以合并层,同时 降低位精度。

下方的表 1 展示了 MKA 与 SmoothQuant、GPTQ 和 AWQ 等量化方法结合的结果。

差异是巨大的。当将 Llama-3-8B 压缩到其原始大小的大约 15% (保留层 + 量化) 时,标准剪枝 (ShortGPT) 的准确率下降到约 26%。 MKA 配合 SmoothQuant 保持了 64.20% 的准确率。 这就是一个坏掉的模型和一个可用模型之间的区别。

可视化相似性

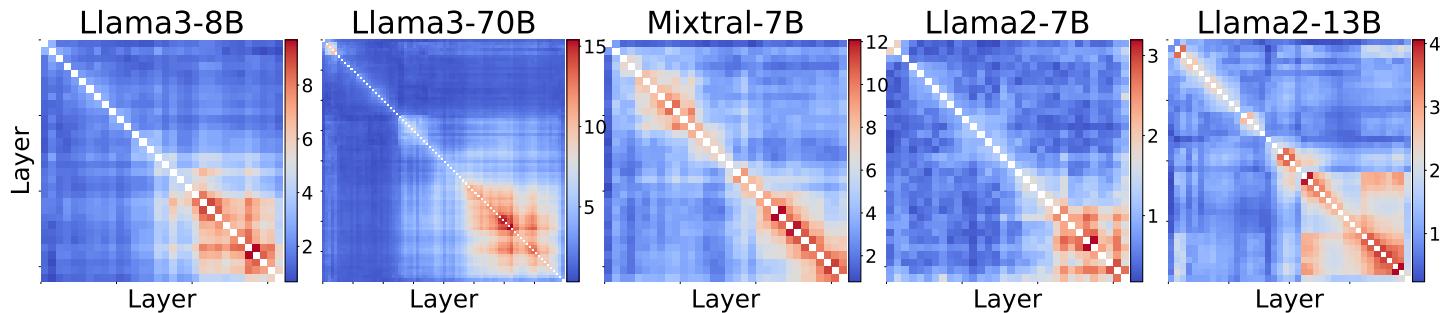

为什么这行得通?我们可以看看由流形学习过程生成的相似性矩阵。

这些热图显示了层之间的相似性。矩阵右下角的亮块 (代表网络的较深层) 表明相似度很高。

- 解读: 这证实了 LLM 中的深层是高度冗余的。它们在反复细化相同的表示。

- “崩溃”点: 注意较早的层 (左上角) 相似度较低。这解释了为什么合并通常针对模型的后期阶段;早期层正在做独特的、基础的工作 (如特征提取) ,不能轻易合并。

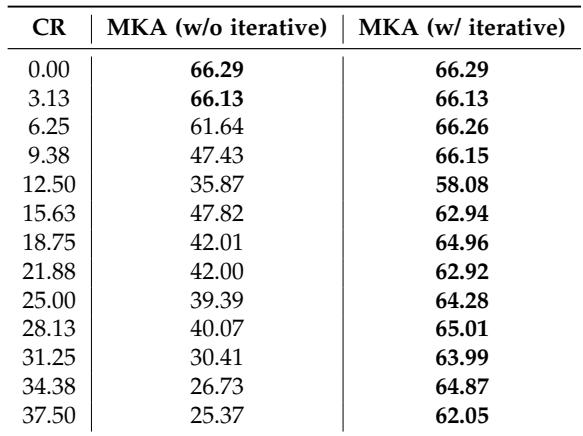

迭代的重要性

MKA 使用迭代方法——合并一对,重新计算,再合并另一对。作者将其与所有合并同时发生的“一次性 (one-shot) ”方法进行了比较。

如表 4 所示,迭代方法 (右栏) 具有显著优势。在 37.5% 的压缩比下,非迭代方法的准确率暴跌至 25%,而迭代式 MKA 保持在 62% 的强劲水平。这表明当层被合并时,流形结构会发生轻微变化,需要在下一次合并之前重新评估网络的几何结构。

讨论: 为什么这很重要

MKA 的意义不仅仅在于让文件变小。

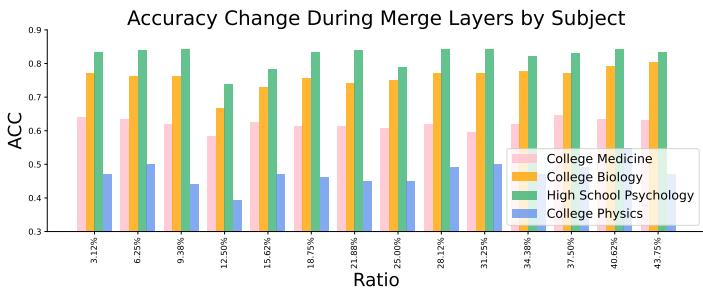

跨学科的鲁棒性

研究人员按 MMLU 数据集中的学科细分了性能表现。

有趣的是,并非所有知识受到的影响都是均等的。

- 高中心理学 (绿色) : 极其稳健。你可以大幅压缩模型而不在此处损失性能。

- 大学物理 (蓝色) : 非常敏感。性能波动剧烈。 这表明“重推理”的任务可能依赖于模型中特定的、精细的回路,这些回路比一般知识任务更容易受到合并伪影的影响。

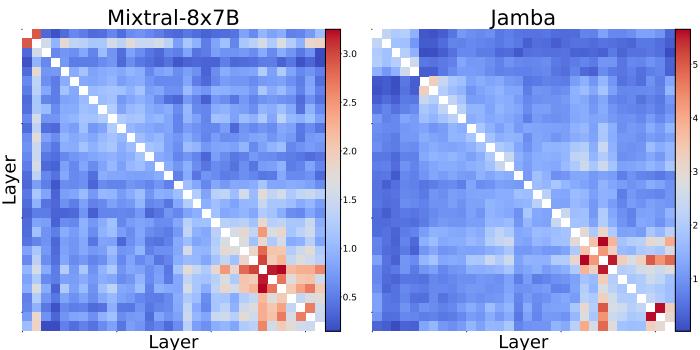

通用性

作者还将 MKA 应用于 混合专家 (Mixture-of-Experts, MoE) 模型 (如 Mixtral) 和混合架构 (如 Jamba) 。

相似性矩阵 (图 4) 看起来有所不同——注意 Mixtral 中的交叉模式。这表明 MoE 模型处理冗余的方式不同,这可能归因于它们的路由专家架构。然而,高相似性区域的存在表明 MKA 也可以适配这些下一代架构。

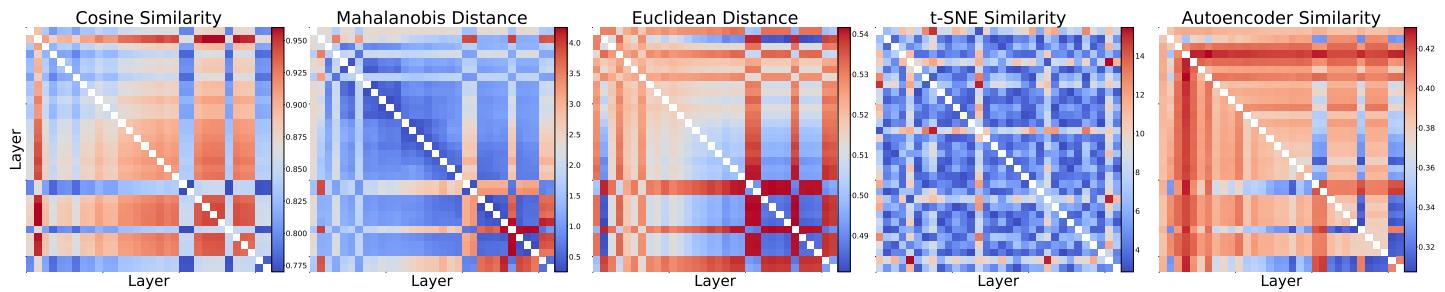

为什么要用流形学习?

最后,作者论证了他们复杂的“流形”方法优于欧几里得距离或余弦相似度等简单指标。

图 5 比较了不同的相似性指标。像 余弦相似度 (Cosine Similarity) (最左侧) 这样的简单指标显示所有内容都有些相似 (大量红色) ,这导致了“误报”——合并了不该合并的层。 基于流形的相似性 提供了更清晰、更结构化的数据视图,允许进行精准的手术式合并,而不是粗暴的组合。

结论

论文“Pruning via Merging”为高效 AI 迈出了令人信服的一步。通过将范式从 减法 (剪枝) 转变为 整合 (合并) ,MKA 保留了 LLM 耗费数周学习到的密集知识网络。

关键要点如下:

- 冗余是几何性的: 层的冗余不仅体现在权重上,还体现在其激活值的形状 (流形) 上。

- 合并,而非删除: 使用信息论融合层比直接移除它们能更好地保留性能。

- 协同效应: MKA 与量化协同工作,解锁了巨大的压缩比 (超过 40-50%) ,这可能将强大的 LLM 带入笔记本电脑和手机。

随着模型持续增长,像 MKA 这样的技术将变得至关重要——不仅为了节省硬盘空间,更是为了让每个人都能使用可访问、可持续且高效的 AI。

](https://deep-paper.org/en/paper/2406.16330/images/cover.png)