谈判是现代生活中压力最大但也最不可或缺的技能之一。无论是买车、谈薪水,还是商定房租,直接为自己争取利益的能力将直接影响你的财务状况。

遗憾的是,学校里很少教授有效的谈判技巧。这是一种“条件反射式的行为习惯”,通常只能通过昂贵的 MBA 研讨会、角色扮演和专家指导来磨练。这种排他性造成了一个鸿沟: 那些最能从这些技能中受益的人群——例如女性和少数族裔,统计数据显示他们往往不习惯自我倡导——却缺乏获得高质量培训的途径。

这就引出了一个迷人的问题: 大语言模型 (LLMs) 能否将这种专属的辅导大众化?

在这篇文章中,我们将深入探讨 ACE (谈判辅导助手,Assistant for Coaching nEgotiation) , 这是哥伦比亚大学研究人员开发的一个新颖系统。ACE 不仅仅是与你聊天;它会观察你的谈判过程,基于 MBA 级别的标准识别具体的战术错误,并教你在下一次做得更好。

当前 AI 导师的问题

近年来大语言模型 (如 GPT-4) 的爆发引发了“AI 导师”的热潮。然而,在涉及软技能时,大多数系统都有一个缺陷。它们充当对话伙伴,但很少提供人类教授那样的结构化、批判性反馈。

仅仅通过与 AI 聊天来练习谈判,就像对着墙打网球。你可以击球,但墙壁不会告诉你握拍方式错了或者站姿无力。要真正学到东西,你需要一位能发现你的错误并解释为什么那是错误的教练。

ACE 试图通过结合对话代理与严格的、专家定义的标注方案 (Annotation Scheme) 来解决这个问题。

第一步: 定义“好的”谈判

在 AI 进行教学之前,它必须知道该看什么。研究人员没有依赖互联网上的通用对话,而是与一位 MBA 谈判课程的讲师合作。

他们收集了一个包含 40 份高质量谈判实录的数据集,这些实录来自 MBA 学生之间的谈判。这些人不是随意的众包工作者;他们是受过讨价还价战术训练的学生,针对现实场景 (如购买二手本田雅阁) 进行谈判。

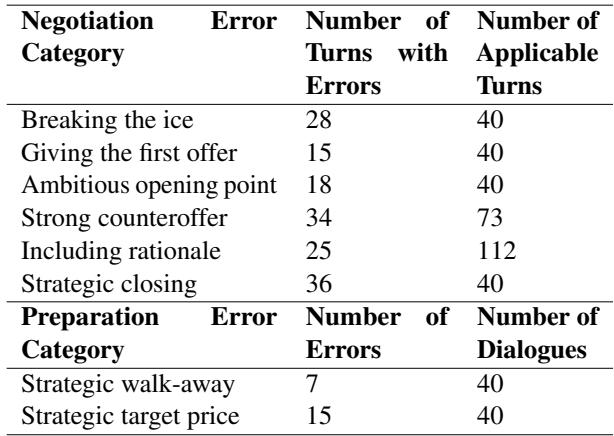

如表 1 所示,该数据集捕捉了真实交易的复杂性,具有不同的成交百分比和金额。利用这些数据和专家咨询,研究人员开发了一套标注方案——用于评估谈判表现的评分标准。

谈判中的 8 种错误

ACE 的核心智能在于其检测八种特定类型错误的能力。这些错误分为准备错误 (聊天开始前) 和谈判错误 (聊天过程中) 。

准备错误:

- 战略性离场点 (Strategic Walk-away Point) : 用户是否根据预算和替代方案计算出了他们应该支付的绝对上限?

- 战略性目标价格 (Strategic Target Price) : 用户是否设定了一个乐观但现实的目标? (太高会把钱留在桌面上;太低则不切实际) 。

谈判错误: 3. 破冰 (Breaking the Ice) : 用户是否以建立社会融洽关系开始? 4. 首次报价 (Giving the First Offer) : 用户是否通过率先报价来锚定谈判? 5. 进取型开场报价 (Ambitious Opening Point) : 第一次报价是否足够激进? 6. 强力还价 (Strong Counteroffer) : 当对手报价时,用户是否进行了有效的还价? 7. 包含理由 (Including Rationale) : 用户是否解释了他们为什么提出这个价格? 8. 战略性收尾 (Strategic Closing) : 用户是否在不沾沾自喜的情况下专业地完成了交易?

表 3 显示了训练数据中这些错误的普遍性。值得注意的是,“战略性收尾”和“强力还价”是常见的绊脚石,这凸显了学生最需要帮助的地方。

第二步: ACE 系统架构

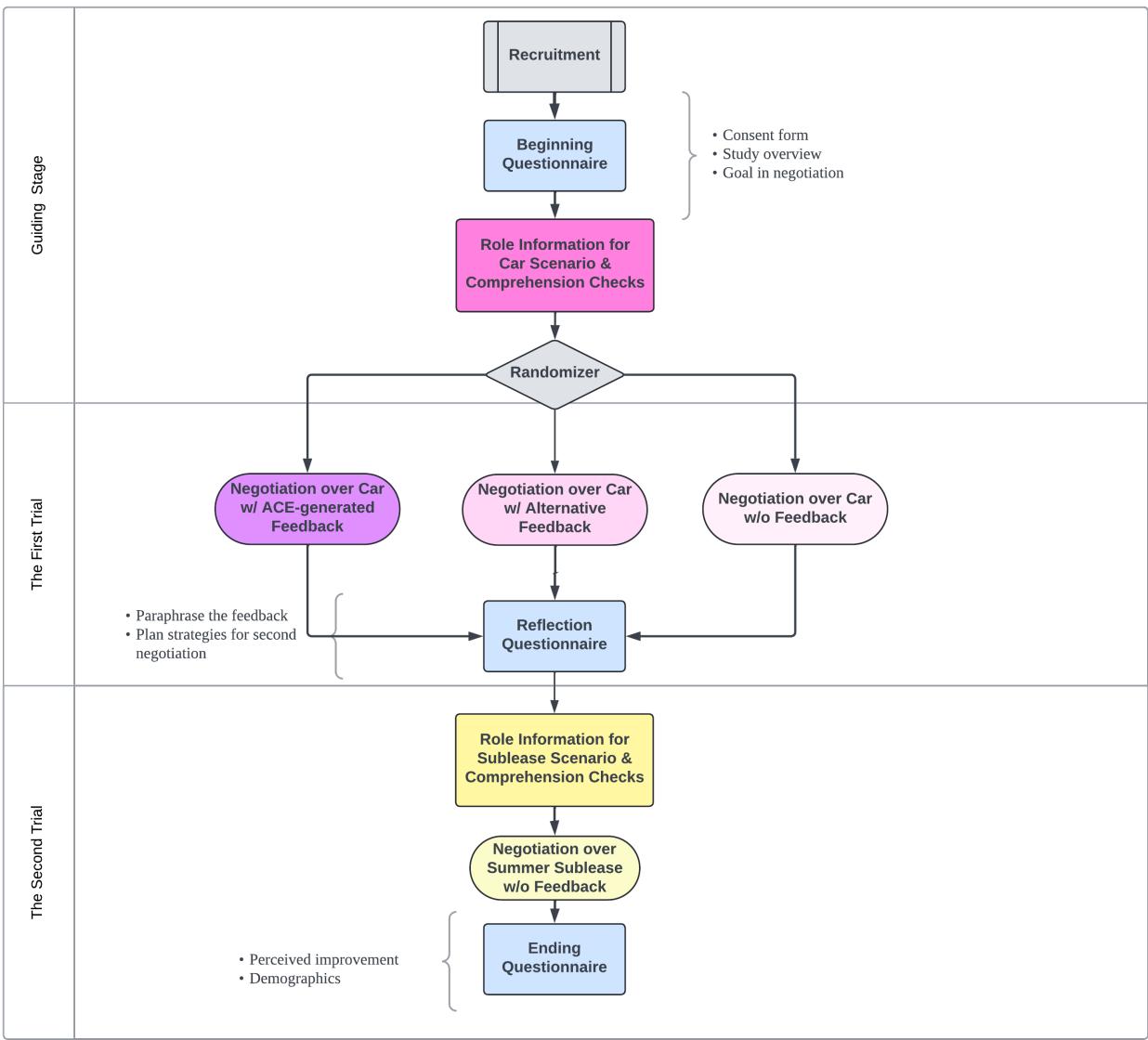

了解了标准之后,让我们看看 ACE 实际上是如何工作的。该系统设计为一个流水线,引导学习者完成一个完整的教育循环。

1. 谈判代理 (The Negotiation Agent)

首先,用户与一个由 GPT-4 驱动的聊天机器人进行谈判。然而,标准的 GPT-4 模型通常太“好人”了——它往往倾向于同意并很容易妥协。

为了解决这个问题,ACE 使用了动态提示 (Dynamic Prompting) 。 代理被赋予一个比其实际离场价格更严格的“主观底线”。随着谈判的进行,这个底线会慢慢放宽。这迫使用户必须为交易付出更多努力,模拟一个强硬的人类谈判者,而不是一个好欺负的机器人。

2. 反馈循环 (The Feedback Loop)

这是 ACE 的亮点所在。一旦谈判结束 (或在对话轮次中) ,系统会分析实录以生成反馈。

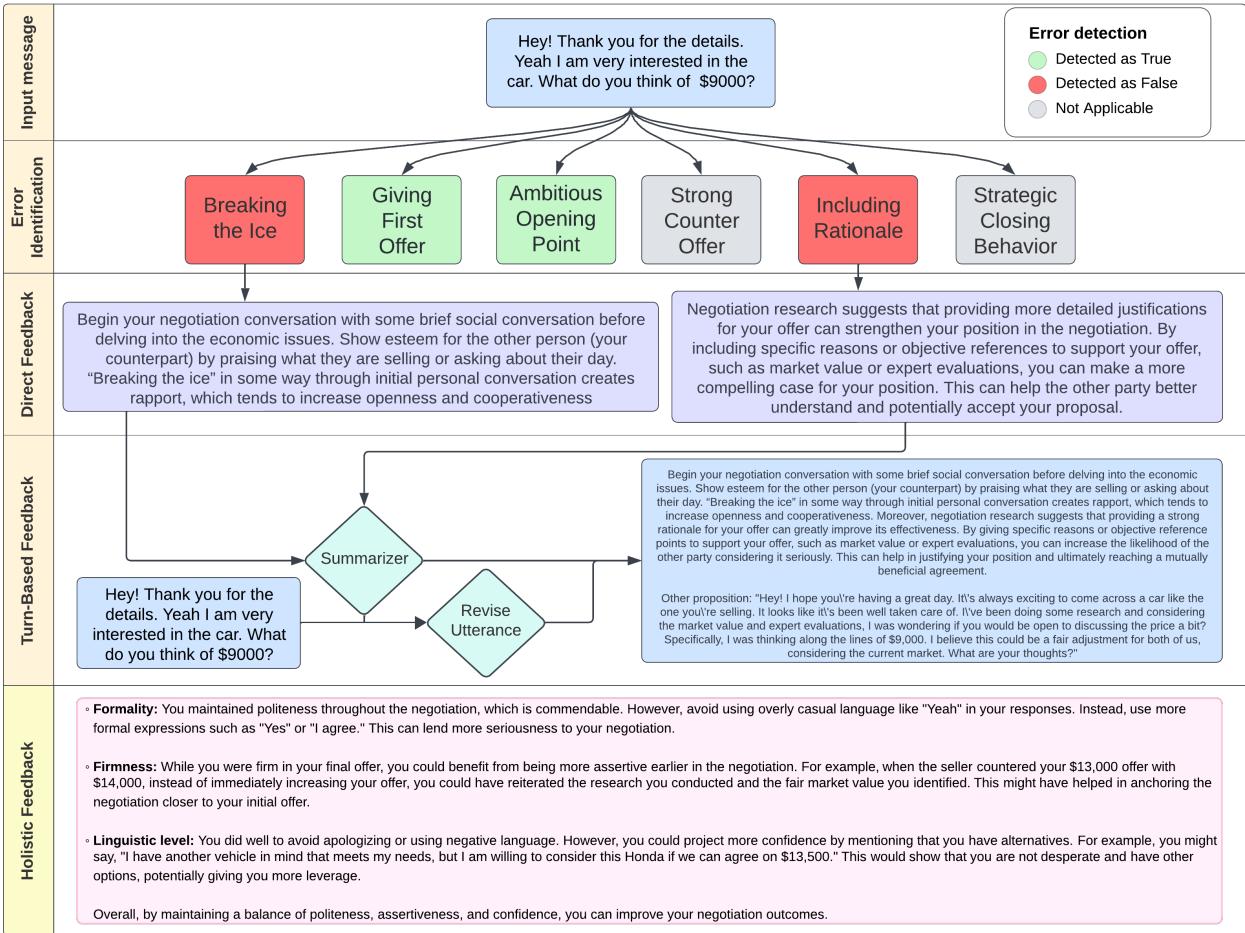

如图 1 所示,反馈流程非常复杂。它不只是猜测,而是使用特定的逻辑路径:

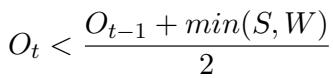

A. 识别数学错误 谈判部分是数学问题。ACE 从文本中提取价格报价,并根据最优公式进行检查。例如,为了检查用户是否进行了强力还价 (\(O_t\)) , ACE 使用以下公式:

*通俗解释: * 你的还价 (\(O_t\)) 应该低于你上一次出价 (\(O_{t-1}\)) 与卖家出价 (\(S\)) 或你的离场点 (\(W\)) 中较低者之间的中点。如果你出的价格高于这个值,说明你过快地让步了太多。

同样,对于进取型开场报价 (Ambitious Opening Point) , 系统会检查开场报价 (\(O_1\)) 相对于目标 (\(T\)) 是否创造了一个有利的锚点:

![]\n{ \\frac { S + O _ { 1 } } { 2 } } \\leq T\n()](/en/paper/2410.01555/images/005.jpg#center)

这个公式确保卖家价格 (\(S\)) 和你开场报价 (\(O_1\)) 之间的中点仍然在你的目标范围 (\(T\)) 内。如果不是,你在谈判一开始就处于劣势位置。

B. 识别语言错误 对于像“包含理由”或“破冰”这样的软技能,公式不起作用。在这里,ACE 使用基于 LLM 的分类器。它将用户的文本输入到旨在检测这些特定行为的模型提示中。

C. 生成反馈 一旦发现错误,ACE 会生成两样东西:

- 直接反馈: 对错误的解释 (例如,“你的还价太高了,因为……”) 。

- 话语修正: 系统重写用户的信息,展示一个更好的谈判者会怎么说。

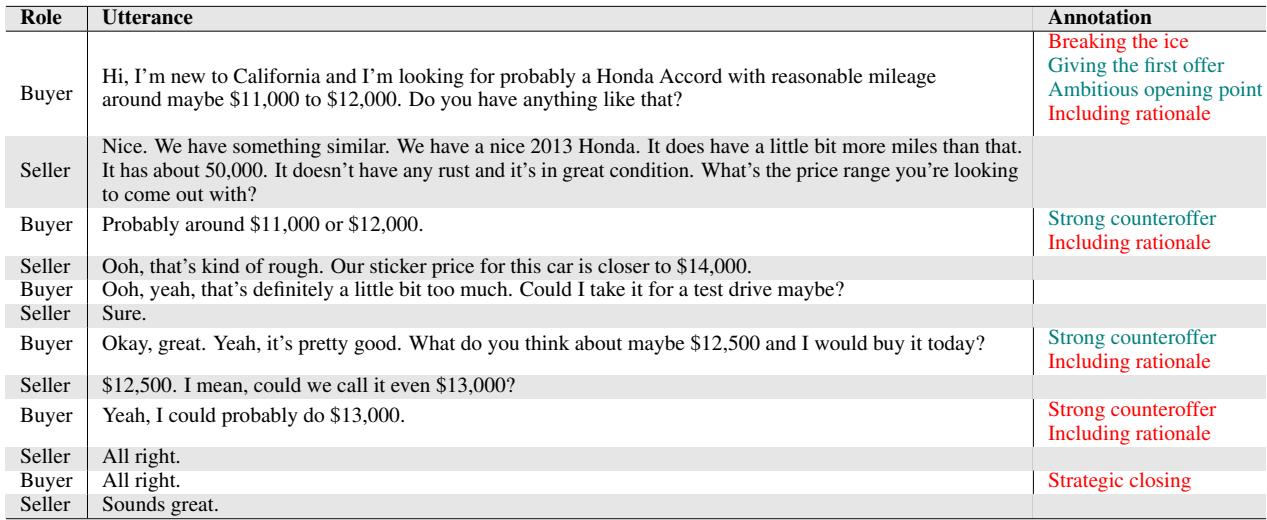

下面是系统看到的内容与它如何标注对话的示例。

在表 2 中,你可以看到系统标记了特定的轮次。例如,当买家说“大概 11,000 到 12,000 美元左右”时,如果买家没有证明为什么这些数字是合理的,系统可能会标记其缺乏强有力的理由。

第三步: ACE 真的有效吗?

研究人员不仅构建了系统,还对其进行了严格测试。评估分为两个阶段: 检查 AI 的准确性和检查学生的学习效果。

第一阶段: 错误识别准确率

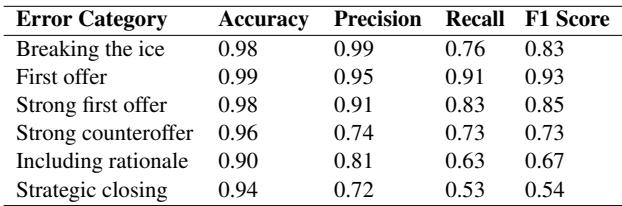

首先,ACE 能正确发现错误吗?研究人员将 ACE 的判断与人类专家的标签进行了比较。

表 4 显示 ACE 具有非常高的准确率 (Accuracy) (所有类别均超过 90%) 。然而, F1 分数 (平衡精确率和召回率) 有所不同。它在发现事实性内容如“首次报价” (0.93 F1) 方面表现出色,但在“战略性收尾” (0.54 F1) 等微妙概念上略显吃力。即使有这些小的局限性,该系统也足够可靠,可以提供一致的辅导。

第二阶段: 人类学习成果

为了观察 ACE 是否真的能帮助人们成为更好的谈判者,研究人员进行了一项有 374 名参与者的用户研究。

实验设置: 参与者被分为三组:

- ACE 组: 与机器人谈判并接收详细的 ACE 反馈。

- 其他反馈组 (Other-Feedback) : 接收由 GPT-4 生成的通用反馈 (这是先前研究中用于 AI 对 AI 谈判的方法) 。

- 无反馈组 (No-Feedback) : 与机器人谈判但不获得任何指导。

参与者进行了两次谈判。首先是“二手车”场景 (训练) ,然后是“暑期转租”场景 (测试) 。目的是看在汽车谈判中学到的技能是否能转移到转租谈判中。

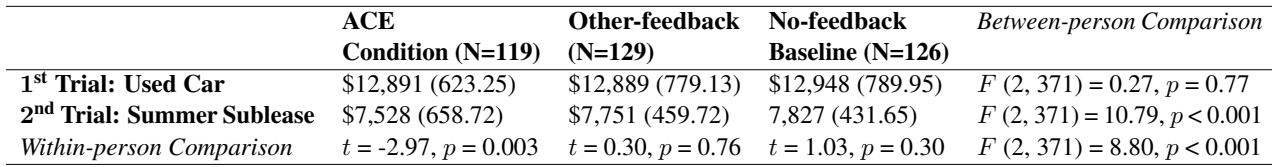

结果: 结果令人信服。衡量成功的主要指标是最终成交价格——对买家来说越低越好。

表 5 清楚地说明了情况:

- ACE 组: 在第二次试验 (暑期转租) 中,他们谈成的价格 ($7,528) 显著低于第一次试验。

- 其他/无反馈组: 他们的表现几乎没有变化甚至变差 (分别支付了 \(7,751 和 \)7,827) 。

这是一个关键发现。仅仅练习 (无反馈) 并没有帮助。甚至接收通用的 AI 建议 (其他反馈) 也没有帮助。 只有来自 ACE 的具体的、基于公式支持的、专家建模的反馈才带来了真正的改进。

此外,ACE 组的参与者感觉更自信。他们对自己感知到的进步评分高于其他组。

结论: AI 辅导的未来

ACE 系统代表了教育技术的重大进步。它超越了将 AI 视为简单聊天机器人的概念,将其定位为一种结构化的教学工具。

通过模仿 MBA 教授的具体反馈策略——识别数学限制、要求提供理由以及批评收尾策略——ACE 证明了软技能可以由机器有效地教授。

其影响远不止于购买二手车。像 ACE 这样的系统可以为薪资谈判、商业交易和冲突解决提供可扩展的高质量培训,使这些关键的生活技能对每个人都触手可及,无论其背景或是否能负担昂贵的教育。

谈判是一门艺术,但正如这篇论文所示,教授它是一门科学——而 AI 正开始掌握它。

](https://deep-paper.org/en/paper/2410.01555/images/cover.png)