社交媒体最初的承诺是乌托邦式的: 一个数字化的城市广场,在那里我们将释放我们“有德行的一面”,寻求新知识,并建立跨越文化鸿沟的联系。如果你最近上过网,就会知道现实已经发生了转变。我们经常看到的不是联系,而是两极分化、回声室效应和恶意。

迄今为止,绝大多数关于在线讨论的计算机科学研究都处于防御状态。研究人员建立模型来检测“坏”事物: 仇恨言论、错误信息和政治极化。虽然这是必要的,但这只是战斗的一半。要真正改善在线讨论,我们不能只抑制消极面;我们必须培养积极面。

这就引出了一篇引人入胜的研究论文,题为 《谦逊的计算解剖学: 在线公共话语中的智力谦逊建模》 (The Computational Anatomy of Humility: Modeling Intellectual Humility in Online Public Discourse) 。 在这项研究中,来自达特茅斯学院和东北大学的研究人员将对话的重点从检测毒性转向了检测美德。具体来说,他们关注的是智力谦逊 (Intellectual Humility, IH) ——即承认自身信念局限性的能力。

本文将探讨这些研究人员如何定义谦逊的“解剖结构”,如何建立庞大的编码本 (Codebook) 来衡量它,以及如何测试最先进的人工智能 (特别是像 GPT-4 这样的大型语言模型) 是否有能力识别这种微妙的人类特质。

核心问题: 为什么谦逊很重要

在深入算法之前,我们需要了解社会科学背景。智力谦逊不仅仅是谦虚;它是一种认知美德。它涉及承认自己的局限性并欢迎不同的观点。

社会科学告诉我们,高水平的 IH 与以下因素相关:

- 对错误信息进行更严格的审查。

- 较少的政治“我方”偏见。

- 减少“情感极化” (仅仅因为某人属于不同群体而厌恶他们的倾向) 。

研究人员选择在一个非常具体且关键的语境中研究这一点: 在线宗教讨论 。 宗教是一个与身份紧密相连的领域,在这里,客观的“真理”是主观的,科学、信仰和不同教条之间的冲突往往导致矛盾。如果我们能够在 Reddit 上的宗教辩论中检测并培养谦逊,我们很可能在任何地方都能做到。

第一部分: 构建谦逊的“解剖结构”

你无法训练计算机去检测你尚未清晰定义的东西。这篇论文的第一个主要贡献是创建了一个严格的 IH 编码本 (IH Codebook) ——一个关于谦逊 (及其对立面,智力傲慢) 在文本中究竟是什么样子的分类法。

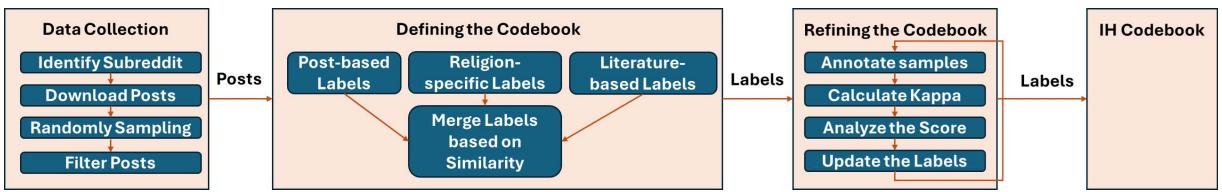

研究人员并不是凭空猜测这些定义。他们采用了一个多步骤、迭代的过程,结合了人类专业知识和 AI 的辅助。

工作流程

如上图所示,该过程是有条不紊的:

- 数据收集: 他们从 48 个以宗教为重点的 subreddit (如 r/Christianity, r/Islam, r/Buddhism) 抓取帖子,得到了超过 17,000 个帖子。

- 定义编码本: 他们结合心理学学术文献和 GPT-3.5 建议的类别,创建了一个初始标签列表。

- 完善编码本: 两名人工标注员将这些标签应用于真实的帖子,计算他们的一致频率 (标注者间一致性) ,并完善定义,直到达到高水平的共识。

从噪声中过滤信号

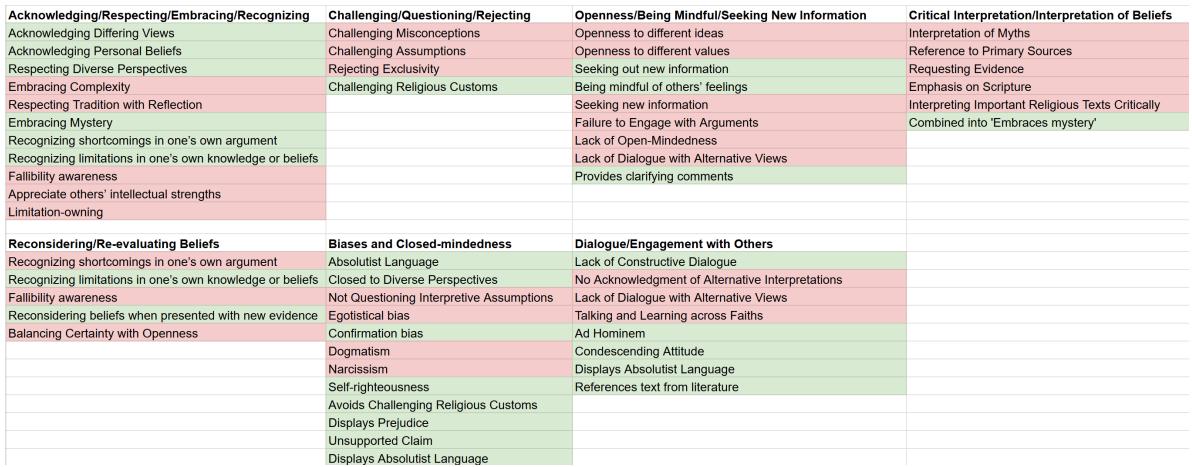

最初的头脑风暴产生了一个包含潜在谦逊和傲慢“标签”的庞大列表——总共 55 个。对于一项可靠的研究来说,这太嘈杂了。研究人员必须合并相似的概念并删除模糊的概念。

上图展示了这一整合过程。例如,像“对不同想法的开放性”和“寻求新信息”这样的具体术语被提炼成更广泛、独特的类别。过于具体或难以证明的术语 (如“自恋”或“自以为是”) 被消除或合并到更可观察的行为中,如“居高临下的态度”。

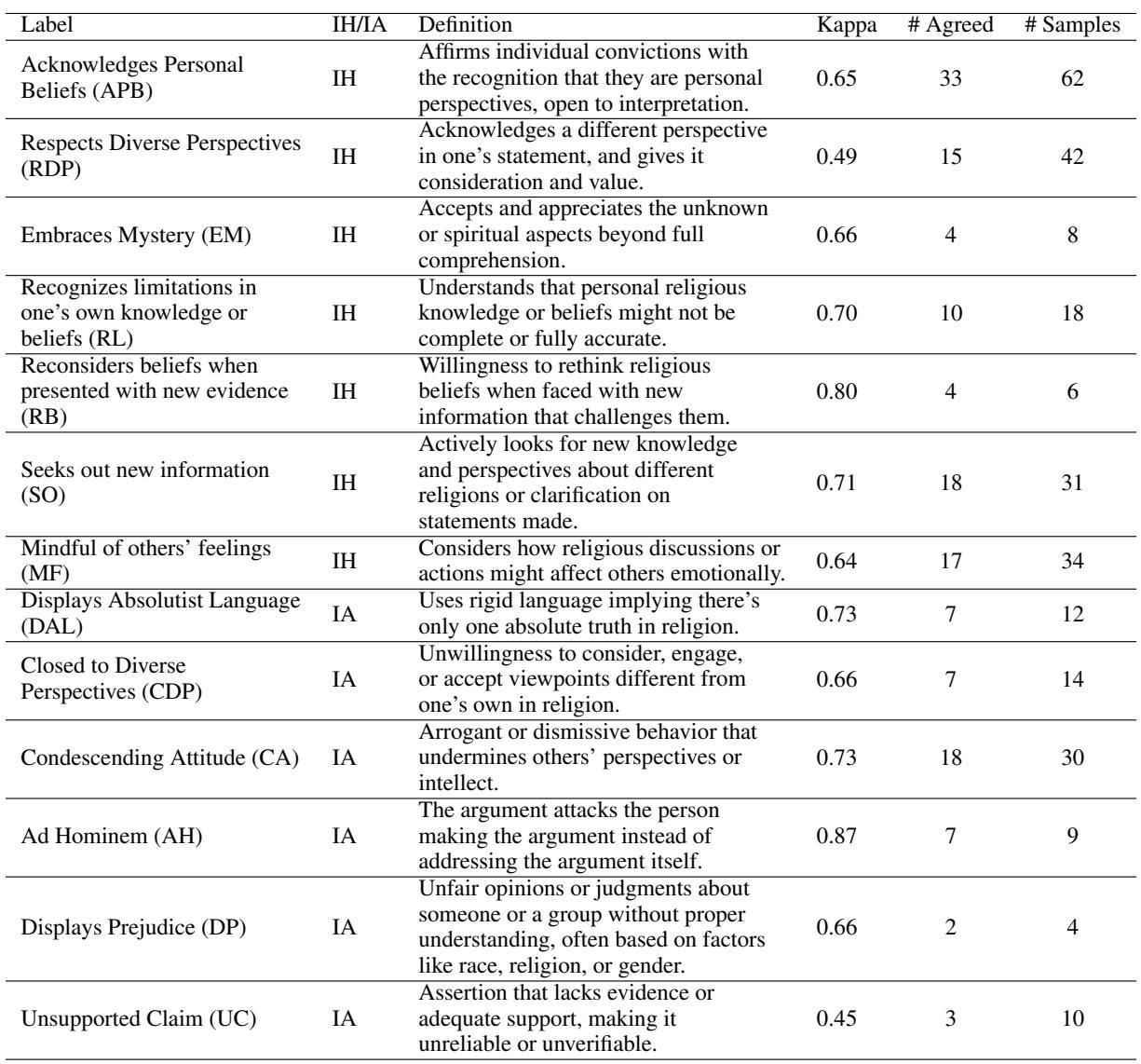

最终编码本

这一严格过程的结果是一个包含 12 个智力谦逊 (IH) 标签和 13 个智力傲慢 (IA) 标签的最终编码本。

这张表是“计算解剖学”的核心。它将抽象的美德分解为可检测的文本特征。

智力谦逊 (IH) 示例:

- 承认个人信仰 (APB) : 将陈述表达为个人信念而非客观事实 (例如,“在我看来……”与“真理是……”) 。

- 拥抱神秘 (EM) : 接受某些精神层面超出了人类理解的范畴。

- 寻求新信息 (SO) : 提问是为了澄清或学习,而不是为了给对手设陷阱。

智力傲慢 (IA) 示例:

- 展示绝对化语言 (DAL) : 使用僵化的词语,如关于信仰的“总是”、“从不”或“无可否认”。

- 居高临下的态度 (CA) : 贬低他人智力的轻蔑行为。

- 人身攻击 (AH) : 攻击人而不是攻击论点。

使用这个编码本,人工标注员对包含 350 个帖子的数据集进行了标注。他们达到了 0.67 的 Cohen’s Kappa 分数,这表明“高度一致”。这个人工标注的数据集成为了测试 AI 模型的“金标准”。

第二部分: AI 能察言观色吗?

有了可靠的数据集,研究人员提出了一个关键问题: 大型语言模型 (LLMs) 能自动化这一过程吗?

检测谦逊比检测关键词要难得多。它需要理解语境、语气和意图。研究人员测试了两个主要模型: GPT-3.5 和 GPT-4 。 他们探索了各种“提示工程”策略,看看哪种方法能产生最好的结果。

实验设置

他们在两个层面上测试了模型:

- 粗粒度分类: 简单地将帖子标记为“智力谦逊”、“智力傲慢”或“中立” (IH/IA/Neutral) 。

- 细粒度标注: 识别特定特征 (例如,“这篇帖子是否表现出尊重不同的观点?”) 。

他们还改变了向 AI 提问的方式:

- 仅代码 (Code-Only) : 只给模型标签名称。

- 仅描述 (Description-Only) : 给定义但不给名称。

- 代码加描述 (C&D) : 两者都给。

- 格式: 通过多项选择列表 (MS) 与 是/否 二元问题 (BQ) 进行提问。

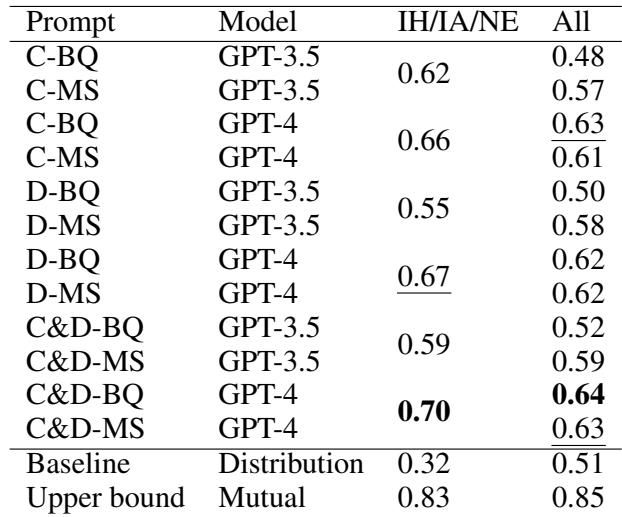

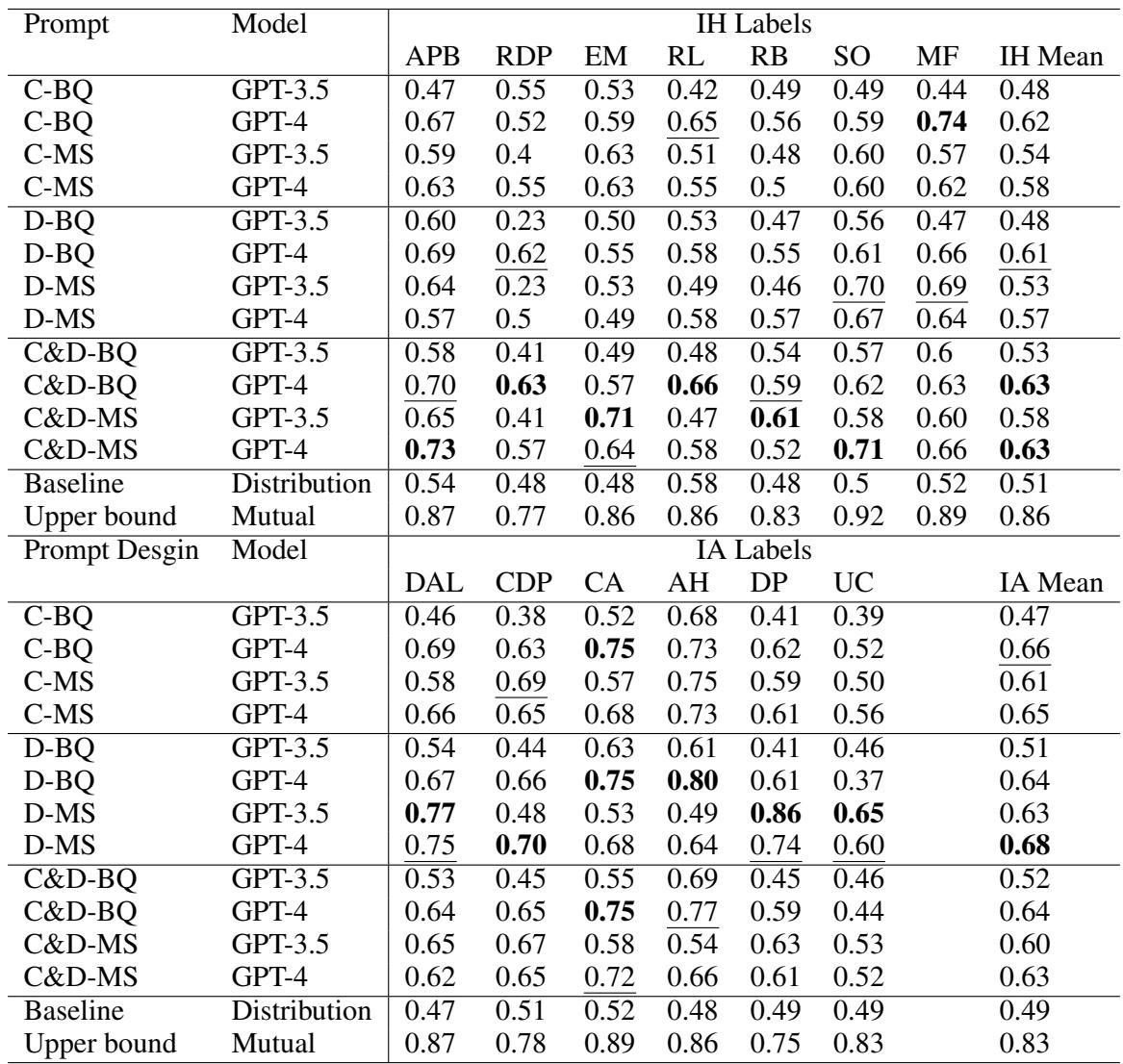

结果

性能使用 F1 分数来衡量,这是一个平衡了精确率和召回率的指标。

上表中的结果揭示了几个关键见解:

- GPT-4 更胜一筹: GPT-4 在几乎所有指标上都持续优于 GPT-3.5。

- 语境很重要: “代码加描述” (C&D) 的提示格式通常效果最好。AI 需要在提示中提供具体的谦逊定义;它不能仅仅依赖其内部训练数据。

- “人类差距”: 最重要的数字在底部。 上限 (Upper Bound) (人类的一致性程度) 是 0.85 。 最好的 AI 表现 (GPT-4 配合 C&D) 是 0.64 。

虽然 AI 的表现明显优于随机猜测 (基线为 0.51) ,但它距离匹敌人类的直觉还有很长的路要走。

深入挖掘: AI 在哪里挣扎?

当我们观察特定标签时,困难就变得更加清晰了。

表 D2 详细列出了细分数据。AI 在检测人身攻击 (0.75 分) 或绝对化语言 (0.69 分) 方面相当不错。这些语言特征通常使用特定的关键词 (侮辱性词汇或像“绝对”这样的词) 。

然而,AI 在处理像尊重不同观点 (RDP) 这样微妙的 IH 概念时很吃力,得分较低 (约 0.63) 。这表明,虽然 AI 可以捕捉到“粗鲁”或“大声”的文字,但它很难检测到真正开放思想的安静优雅。

第三部分: 我们可以增强 AI 吗?

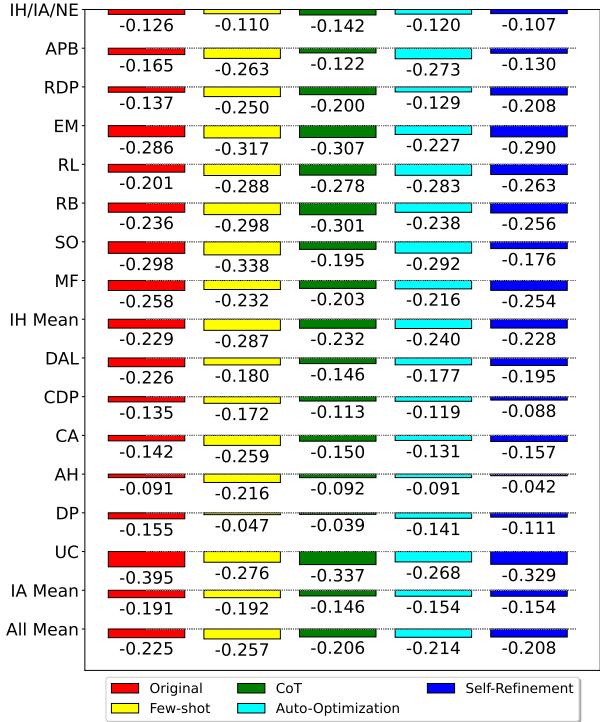

由于标准提示没有达到人类水平的性能,研究人员尝试了先进的技术来“增强”模型。

他们测试了:

- 少样本学习 (Few-Shot Learning) : 在要求模型分类之前,给它提供 3 个正面和负面的帖子示例。

- 思维链 (Chain-of-Thought, CoT) : 要求模型在给出最终标签之前“解释其推理过程”。

- 自动优化 (Auto-Optimization) : 使用 LLM 自动重写和改进提示。

- 自我完善 (Self-Refinement) : 要求模型批评自己的答案并重试。

这张图表显示了模型与人类表现之间的差距 (负值意味着 AI 比人类差) 。

令人惊讶的发现:

- 少样本学习实际上在某些情况下损害了性能 (可能是由于过度拟合所提供的少数示例) 。

- 思维链 (CoT) 和自我完善有所帮助 , 使粗粒度的“IH/IA/Neutral”检测非常接近人类水平。

- 然而,对于特定的标签 (顶行以下的行) ,仍然存在显著差距。

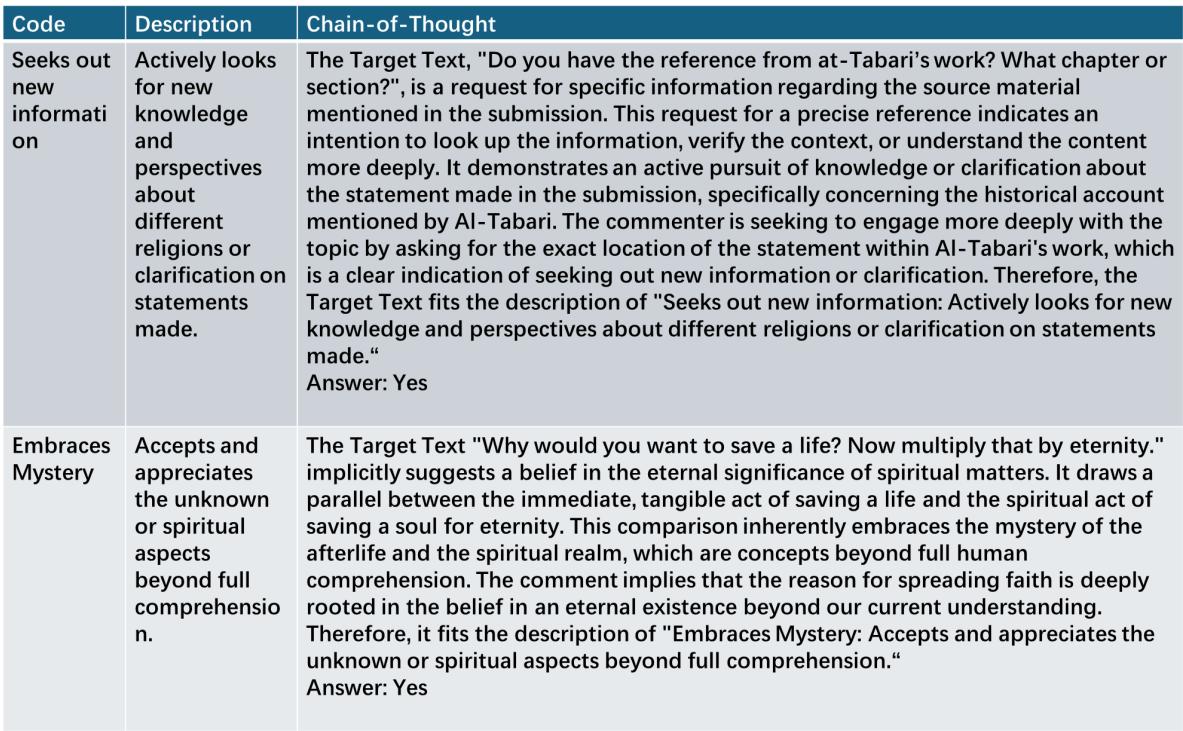

观察 AI “思考”

为了理解模型为何成功或失败,查看思维链的输出是非常有启发性的。

在图 E2 的第二个例子中,我们看到了一个失败案例。这篇帖子讨论了“拯救生命”和“永恒”。模型产生幻觉,认为这是“拥抱神秘”,因为它提到了永恒。然而,人类读者可能会认为这是一种神学主张,而不是对知识局限性的谦逊承认。AI 混淆了谈论精神概念与拥有智力谦逊。

结论: 具备美德的 AI 的未来

论文《谦逊的计算解剖学》开启了自然语言处理的一扇新大门。它使我们从简单地标记“坏词”转向理解高层次的认知美德。

主要收获:

- 谦逊可以被编码: 为在线帖子中的智力谦逊建立严格的分类法是可能的。

- 人类仍然至关重要: 当前的 AI 模型 (即使是 GPT-4) 无法完全复制人类对谦逊的辨别力,尽管它们正变得越来越接近。

- 提示很强大: 我们向 AI 提问的方式至关重要。给 AI 定义并要求它“展示工作过程” (思维链) 可以显著提高准确性。

###这对现实世界意味着什么

想象一下未来的社交媒体平台,它使用这些模型不是为了封禁你,而是为了助推 (nudge) 你。在你点击“发布”进行激烈的辩论之前,算法可以分析你的草稿并说:

“看起来你正在使用绝对化的语言。你愿意重新措辞以承认这是你的个人观点吗?这可能会带来更有成效的对话。”

通过构建衡量谦逊的计算基础设施,这些研究人员为不仅能连接我们,而且可能使我们彼此变得更好的技术奠定了基础。虽然这项技术还不完美,但“解剖结构”已经被定义——现在的任务是未来的研究将其变为现实。

](https://deep-paper.org/en/paper/2410.15182/images/cover.png)