想象一下,你正试图学习一项复杂的技能——比如精通一款新的视频游戏或操作一个机器人——但你只能使用其他人的操作录像。你无法亲自与环境互动,只能通过观察去推断规则。你会如何找到成功的正确策略?

这是人工智能的一大挑战: 仅依靠离线数据,在没有试错互动的情况下,让智能体能够在复杂环境中有效行动。这种方法在机器人等现实场景中至关重要,因为每次实验都可能缓慢、昂贵,甚至存在安全风险。

一个强大的解决方案是世界模型——一种直接从视频数据中学习环境规则和物理规律的神经网络。训练完成后,这个模型便成为一种梦境引擎 , 让智能体能够在自身的想象中进行练习。它们可以完全离线地模拟体验并学习策略。

然而,直到最近,构建既精确又快速的世界模型以支持想象力训练仍很困难。早期模型要么错误地呈现物体间的交互,要么每一步模拟都消耗巨大的计算资源。

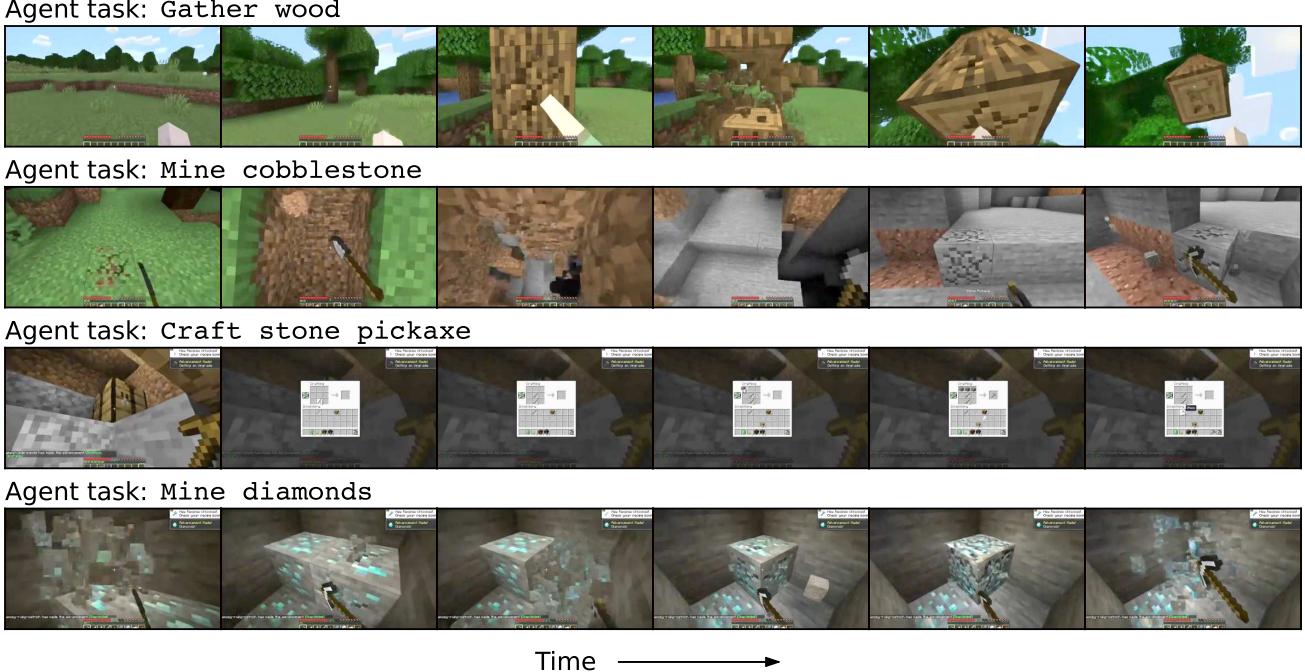

在最新论文 《在可扩展世界模型中训练智能体》 (Training Agents Inside of Scalable World Models) 中,来自 Google DeepMind 的研究人员推出了 Dreamer 4 , 一个成功克服这些障碍的智能体。Dreamer 4 完全在自己想象的世界中进行训练,无需直接环境交互,即可学习复杂的长时程行为。它取得了前所未有的成果——成为第一个仅通过离线游戏数据就在 《我的世界》 (Minecraft) 中成功获取钻石的 AI,而这是游戏中最具挑战的目标之一。

图 1: Dreamer 4 通过完全在游戏世界的内部模拟中训练,学会了在《我的世界》中执行长时程任务。

背景: 生成模型的构建基石

在了解 Dreamer 4 的工作原理之前,有必要先理解它所基于的技术基础。Dreamer 4 的世界模型是一种基于扩散的生成模型 , 这是一种用于生成图像和视频等复杂数据的现代框架。

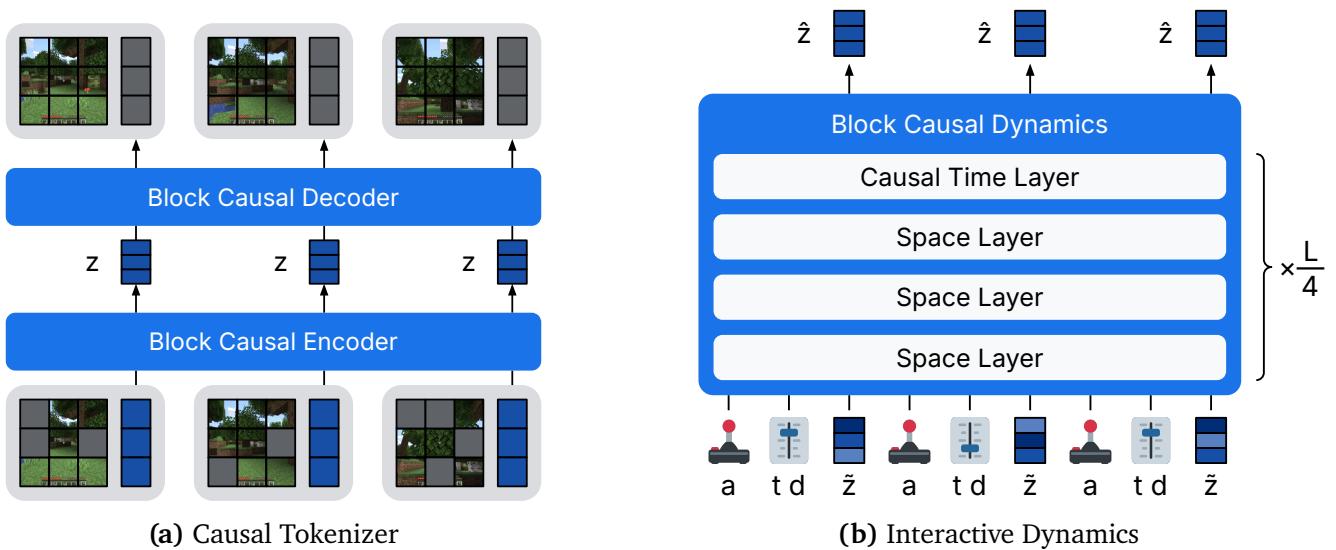

流匹配 (Flow Matching)

在标准扩散模型中,噪声会逐步添加到干净数据中,直到其与随机噪声无法区分。神经网络则学习反向此过程——逐步去噪。

流匹配简化了这一过程。模型不再通过数千次迭代添加和移除噪声,而是学习从纯噪声 \(x_0\) 到干净数据 \(x_1\) 的直接路径。每个中间状态由信号水平 \(\tau \in [0,1]\) 定义:

\[ x_{\tau} = (1 - \tau)x_0 + \tau x_1 \]模型 \(f_{\theta}\) 预测一个速度向量 \(v = x_1 - x_0\),它从噪声直指数据。训练时,模型最小化预测与真实速度之间的平方差:

\[ \mathcal{L}(\theta) = \| f_{\theta}(x_{\tau}, \tau) - (x_1 - x_0) \|^2 \]在推理阶段,模型从噪声出发,沿着学得的方向逐步生成逼真的输出。

快捷模型 (Shortcut Models) : 加速生成

传统扩散模型往往需要数百或数千个微小步骤才能生成一张图像——计算代价极高。 快捷模型通过教会模型“跳跃”而非“爬行”来解决这一问题。

在训练中,快捷模型学习如何执行大幅而准确的跳跃,并以目标步长 \(d\) 作为条件。通过一个自举损失 (bootstrap loss) 进行引导,将大步结果与两步较小中间结果进行比较。

快捷训练使模型在推理时能够采用更大步长,将原需数百步的生成过程减少到仅需几步高质量推理。

这一创新使模型仅需 2–4 步 即可生成高质量样本,而非数百步——这对于 Dreamer 4 实现实时模拟至关重要。

扩散强制 (Diffusion Forcing) : 生成视频序列

视频生成引入了时间维度挑战,每一帧都依赖于前一帧。 扩散强制为每一帧分配独特的噪声水平,使其既能作为去噪目标,又能为后续帧提供上下文。这一机制帮助模型学习连贯的时间动态——对预测动作如何改变场景至关重要。

Dreamer 4 的架构

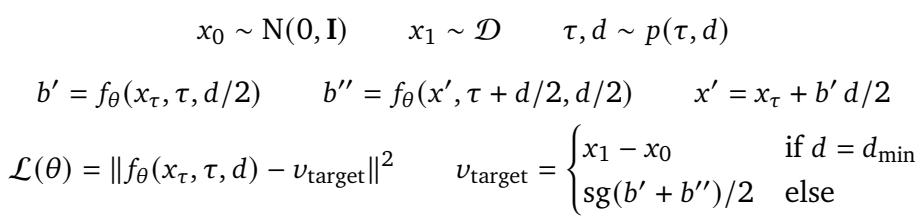

Dreamer 4 是一个以可扩展世界模型为核心的完整智能体系统,由两个关键组件组成:

- 因果分词器 (Causal Tokenizer) – 将视频帧压缩为紧凑的连续表示。

- 交互式动态模型 (Interactive Dynamics Model) – 模拟世界如何随动作而演化。

两者基于一个高效的 Transformer 架构 , 专为高吞吐量时序数据设计。

图 2: Dreamer 4 的架构结合了用于编码视频帧的因果分词器与用于根据动作预测未来帧的交互式动态模型。

训练分三个阶段进行:

- 世界模型预训练 – 从离线视频中学习环境物理规律。

- 智能体微调 – 添加行为与奖励预测能力。

- 想象力训练 – 完全在模拟世界中强化策略。

因果分词器: 高效地感知世界

在强化学习中,每帧视频的尺寸都过于庞大。 因果分词器将高维图像转换为更小的潜在“令牌” (tokens) 集合。它采用编码器–解码器架构: 编码器压缩视觉信息,解码器在需要时重建画面。

为提高鲁棒性,分词器使用 掩码自编码 (Masked Autoencoding, MAE) : 训练时,随机遮住图像部分,迫使模型推断缺失的细节。这促进了对场景的深层语义理解,而非仅仅匹配像素。分词器在时间上是因果的,即仅由过去帧影响当前编码——这对于流媒体类交互场景尤为重要。

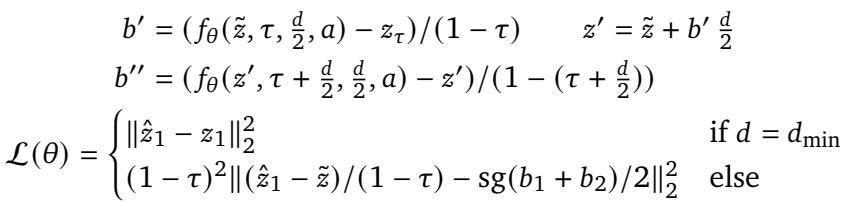

交互式动态: 梦境引擎

Dreamer 4 的核心是其交互式动态模型 , 相当于学习到的梦境世界的“物理模拟器”。

动态模型输入编码后的图像令牌和动作序列 (如鼠标移动、键盘按键) ,预测后续帧中这些动作将如何改变世界。其高效与精准源自一种新颖的训练目标: 快捷强制 (Shortcut Forcing) 。

X-预测 (以干净表示为目标) : 模型不再预测状态差异的速度 (v-预测) ,而是直接预测干净的潜在表示 \(z_1\) (x-预测) 。这防止了长序列推理中常见的高频误差累积,使视频生成在数千帧范围内保持稳定。

X-空间自举损失 : 快捷模型的自举训练在 x-预测中得到改进。它确保一个大模拟步与多个小步结果一致,从而在加速推理的同时保留准确性。

Shortcut Forcing 在 x-空间中结合流匹配与自举目标,使 Dreamer 4 能稳定且快速地模拟序列。

- 斜坡损失权重 : 对于高噪声帧,学习信号极弱,Dreamer 4 将损失按信号水平 \(\tau\) 线性缩放:

从而让模型集中在信息最丰富的区间。

这些创新使 Dreamer 4 只需四次前向传播即可生成下一帧,在单个 GPU 上实现实时速度。

想象力训练: 在梦境中学习行动

当内部模拟器构建完成后,Dreamer 4 就成为一个能在自身想象中学习的智能体。

在微调阶段中,为 Transformer 添加了新的头: 一个用于预测动作 (策略头) ,另一个用于预测奖励 。 它们首先在离线数据集上通过行为克隆训练,模仿人类玩家行为。

但单靠模仿不足以超越数据集。为了发现更优策略,Dreamer 4 使用想象力训练——一种完全在模拟世界中进行的强化学习方法。

在想象力训练中,PMPO 目标仅依据世界模型生成的模拟轨迹来更新策略。

Dreamer 4 会在梦境中展开想象轨迹: 从策略采样动作,经世界模型模拟后得到结果,再由奖励头生成奖励。一个价值头预测累计奖励,以优化长期收益。

该训练目标称为 PMPO (作为概率推断的偏好优化) , 它依据结果是否优于预期来更新策略,而不依赖数值幅度,从而避免因奖励尺度变化带来的不稳定,并保证任务间学习的平衡性。

实验: 测试 Dreamer 4

研究团队在开放世界沙盒游戏 《我的世界》 中对 Dreamer 4 进行了系统评估,这是一项高度复杂的视觉控制基准。

离线钻石挑战

终极测试是: Dreamer 4 能否学会获得钻石 ?这一任务要求掌握长序列动作——砍树、制作工具、深入地下采矿——每回合约需执行 24,000 次鼠标与键盘事件。

训练使用了 VPT Contractor 数据集 (共 2,500 小时人类游戏录像) 。关键之处在于,Dreamer 4 的学习完全离线 , 没有任何实时环境交互。

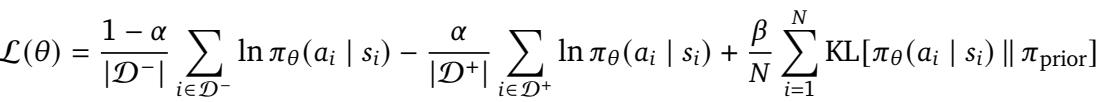

图 3: Dreamer 4 显著超越以往离线智能体,成为第一个纯靠录制数据即能收集钻石的模型。

结果令人惊叹。Dreamer 4 在中间任务 (制作石制工具) 上成功率超 90%,在制作铁镐上达到 29%,并在 0.7% 的回合中成功获得钻石——这是此前未曾在无在线数据条件下实现的里程碑。

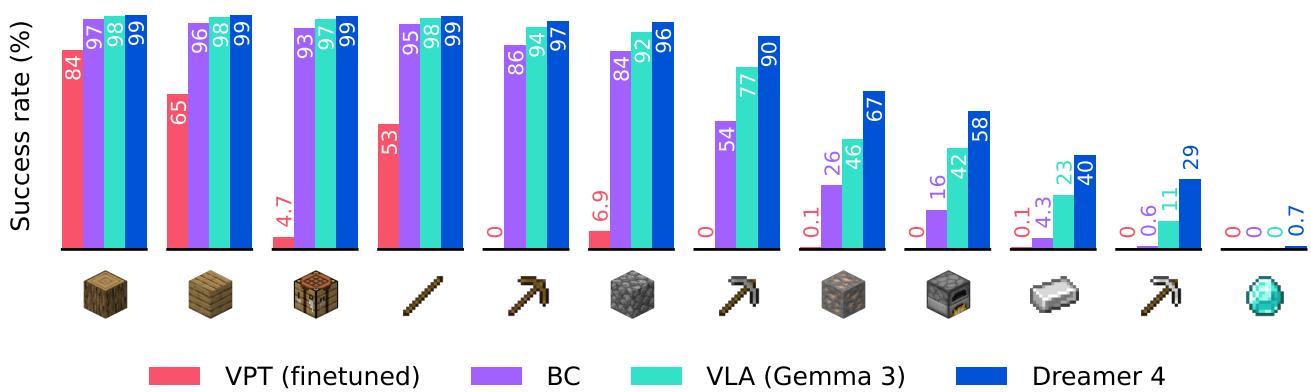

进一步消融研究表明,想象力训练是关键环节:

图 4: 与纯行为克隆相比,想象力训练显著提升任务成功率与效率。

Dreamer 4 缩短了达成目标所需时间,并始终优于所有基线模型,包括 OpenAI 的 VPT 及视觉语言模型 Gemma 3。

人类交互: 在梦境中玩耍

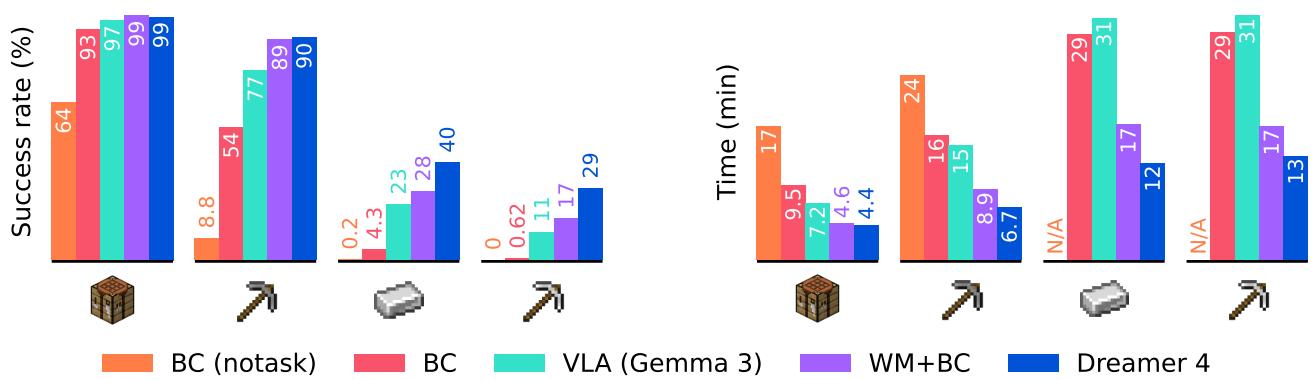

为验证世界模型物理模拟的真实度,研究人员邀请人类玩家在 Dreamer 4 的模拟环境内部进行互动。玩家使用鼠标与键盘尝试任务,如搭建一个 3×3 墙,并与以往模型 (Oasis、Lucid) 对比。

图 5: Dreamer 4 是首个能精确模拟复杂交互的世界模型,使人类可在想象世界中自由建造与操作。

Dreamer 4 能准确预测每个动作的效果,实现真正的游戏式交互。而其他模型常出现画面模糊、物品错乱或“幻觉”结构等问题。

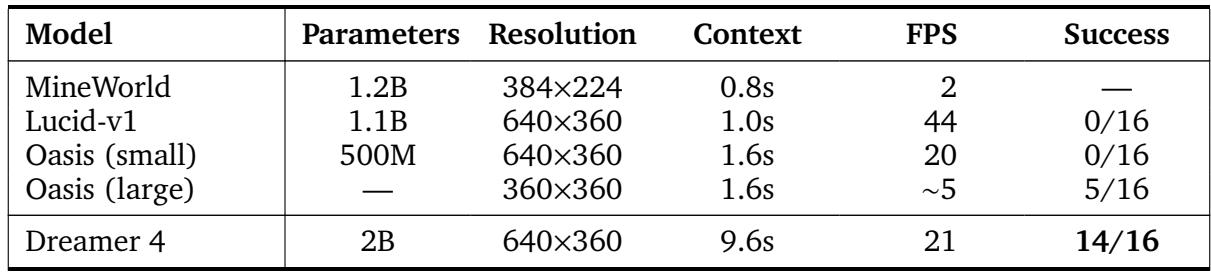

表 1: 《我的世界》世界模型对比。Dreamer 4 拥有最长的时间上下文并实现实时帧率性能。

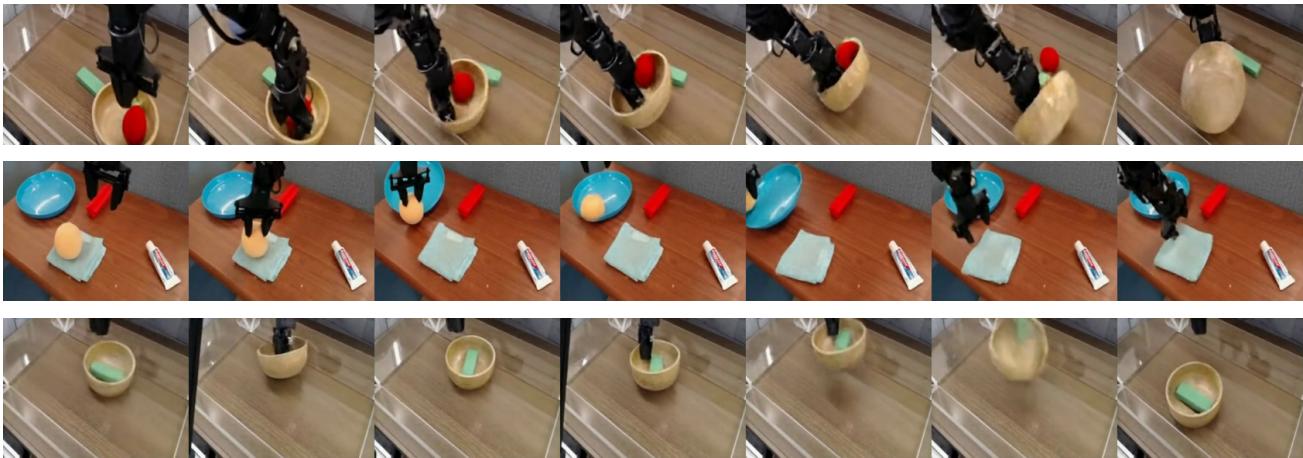

当应用于真实世界数据时,Dreamer 4 亦能掌握机器人模拟 , 学习精准的拾取与放置任务物理规律。

图 6: Dreamer 4 应用于机器人领域。其世界模型可实时模拟逼真的物理交互。

从未标注的视频中学习

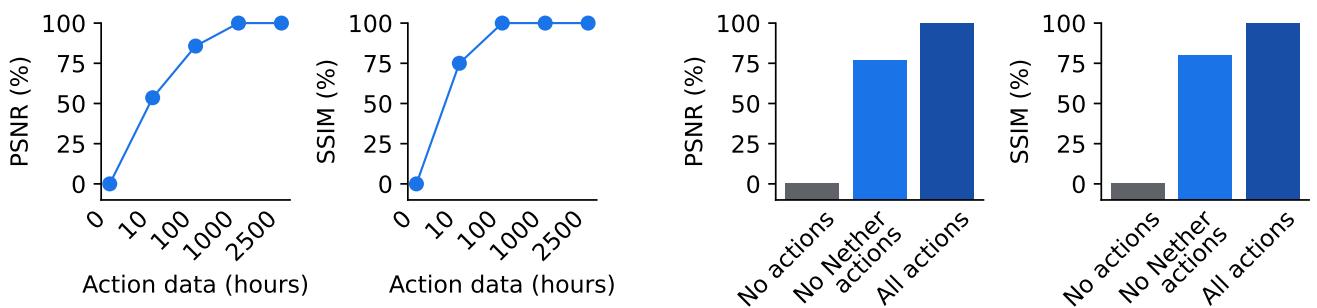

世界模型的一个关键优势是能从视频中学习通用结构。研究人员测试了 Dreamer 4 对动作标注数据的需求程度。

图 7: 仅用 100 小时动作数据 (约占总量 4%) ,Dreamer 4 即能实现近乎完美的动作条件化,并泛化到未探索环境如下界 (Nether) 。

在使用全部 2,500 小时视频、但仅 100 小时动作标注的数据下,Dreamer 4 达到几乎与完全监督训练相当的生成质量。更令人惊喜的是,当仅用主世界动作训练时,它仍成功泛化至下界 (Nether) 和末地 (End) 等全新生物群系——表明有限数据的动作归因可广泛迁移。

为什么它既快又准

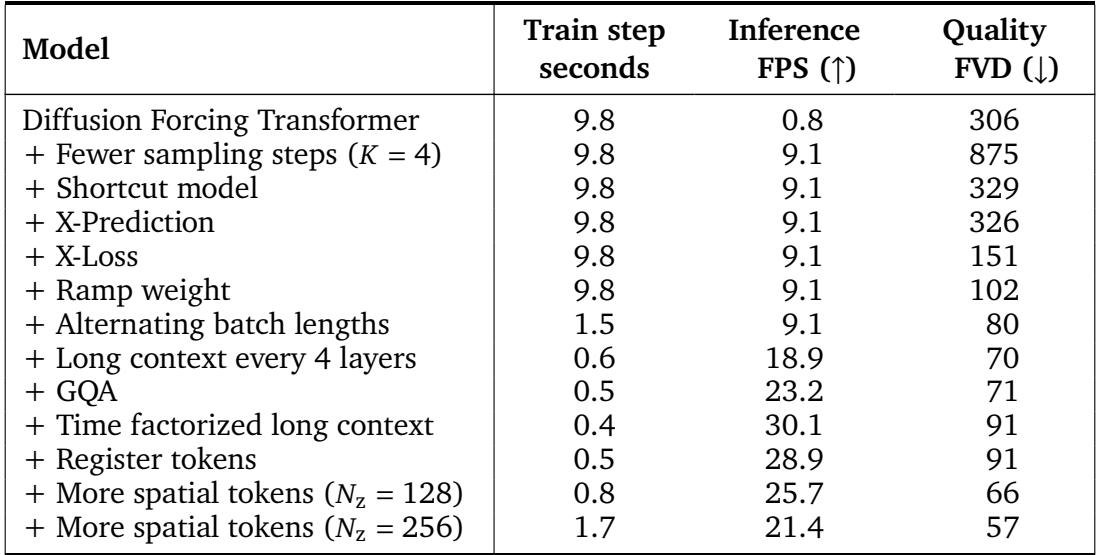

团队对 Dreamer 4 的设计进行逐层剖析,从基础版本开始,逐步加入效率改进。

表 2: Dreamer 4 架构的层次改进。每项设计都提高了生成质量 (更低 FVD) 或推理速度 (更高 FPS) 。

最初,朴素的扩散强制仅能达 0.8 FPS。引入快捷建模后,速度提升到 9.1 FPS,质量保持稳定。随后加入 x-预测、x-损失、斜坡权重及架构优化,将交互推理速度提升到 20 FPS , 媲美实时游戏。

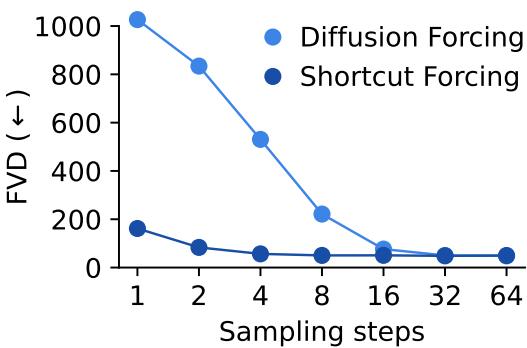

图 8: Shortcut Forcing 以标准扩散强制十六分之一的采样步数实现近乎相同的生成质量。

这一架构与训练策略的结合,造就了一个既高保真又实时可用的世界模型,为可扩展的想象力训练奠定了重要里程碑。

结论与展望

Dreamer 4 代表了世界模型与自主智能体学习的重大突破。其创新——快捷强制、因果分词、高效 Transformer 架构——共同实现实时、可扩展的想象力训练。

主要收获:

- 想象力训练有效 : 智能体可在自学世界模型中练习,超越人类演示。

- 速度与精度兼备 : 快捷强制与高效架构让模型能直接从原始像素实时模拟精确环境。

- 从视频学习可行 : 仅需少量带标签动作,其余可来自视频观察。

这些成果打开了新的可能: 在多样化网络视频上预训练,将世界模型应用于机器人领域,融合语言理解,并扩展至可在无限时间尺度上推理的智能体。

Dreamer 4 不仅会想象——它还能逼真地做梦。正是在这种梦境中,它展示了智能体或许有一天能通过想象,而非试错,学会理解世界的复杂性。

](https://deep-paper.org/en/paper/2509.24527/images/cover.png)