大型语言模型 (LLM) 的能力惊人,但它们的自信也同样危险。当一个LLM生成听起来完美无瑕、但实际上完全错误的医疗诊断或法律分析时,问题不仅在于准确性,更在于错位的确定性。在高风险领域,未经校准的置信度会将错误转化为风险。

要让LLM成为真正值得信赖的伙伴,它们需要认识到自身的不确定性。换句话说,当一个模型声称自己有 90%的置信度 时,这应该意味着它在90%的情况下确实是正确的。实现这种一致性被称为置信度校准 (confidence calibration) ,这是人工智能安全领域中最棘手的问题之一。

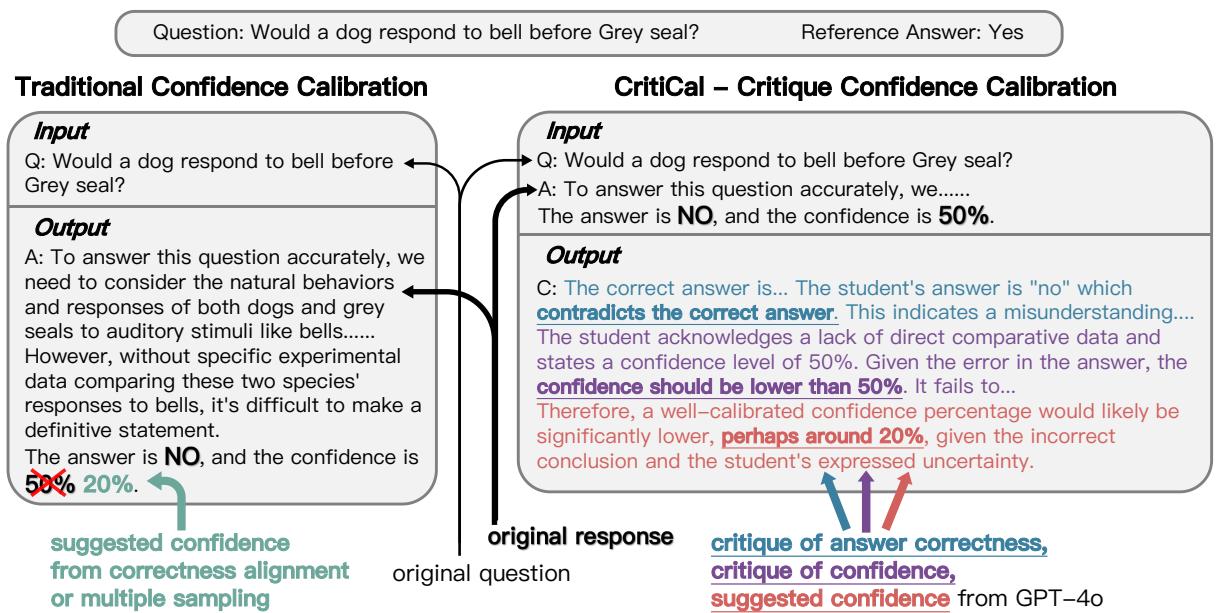

香港科技大学的研究人员最近发表了题为《CritiCal: 评判能否帮助LLM进行不确定性或置信度校准?》的研究,提出了一个颇具趣味的解决方案。与其尝试猜测正确的置信度数值,他们让模型学习评判 (critique) 自己的推理——理解为什么自己的置信度可能被错误地置入不恰当的位置。该方法名为CritiCal , 利用自然语言评判微调LLM,使其能够更准确地表达已校准的置信度。值得注意的是,经过CritiCal训练的模型甚至能够超越它们的“老师”——GPT‑4o。

接下来,让我们探索CritiCal的工作机制,以及它如何帮助LLM变得不仅更智能,而且更具自我认知。

理解校准挑战

传统的校准方法通常分为两类:

白盒方法 : 从模型内部提取信号——例如词元概率或隐藏状态——来推断模型的确定性。虽然精确,但必须访问模型内部结构,这对闭源API来说不可行。

黑盒方法 : 仅依赖模型的输出行为。常见的例子包括基于一致性的采样 (通过多次查询测试响应稳定性) ,或基于语言表达的训练 (明确教模型表述置信度,例如: “答案是巴黎,我的置信度是95%”) 。

问题在于,这些策略往往只是教模型模仿自信的表述,而非真正推理自己的确定性。为此,香港科技大学的研究人员转向了评判——以自然语言反馈解释为什么一个答案或其推理过程是错误或不确定的。

评判此前曾用于提升事实准确性,但这是首次系统性地尝试将其用于置信度校准 。

评判什么: 不确定性 vs. 置信度

研究首先探讨了一个看似简单的问题: 我们该评判不确定性还是置信度 ?

- 不确定性指的是对问题本身的疑问 (“这个问题有多难或多模糊?”) 。

- 置信度指的是对给出的特定答案的把握程度 (“我有多确定这个答案是正确的?”) 。

为了比较两种方式的效果,研究者让五个不同的LLM在六个基准测试中分别表达不确定性或置信度。

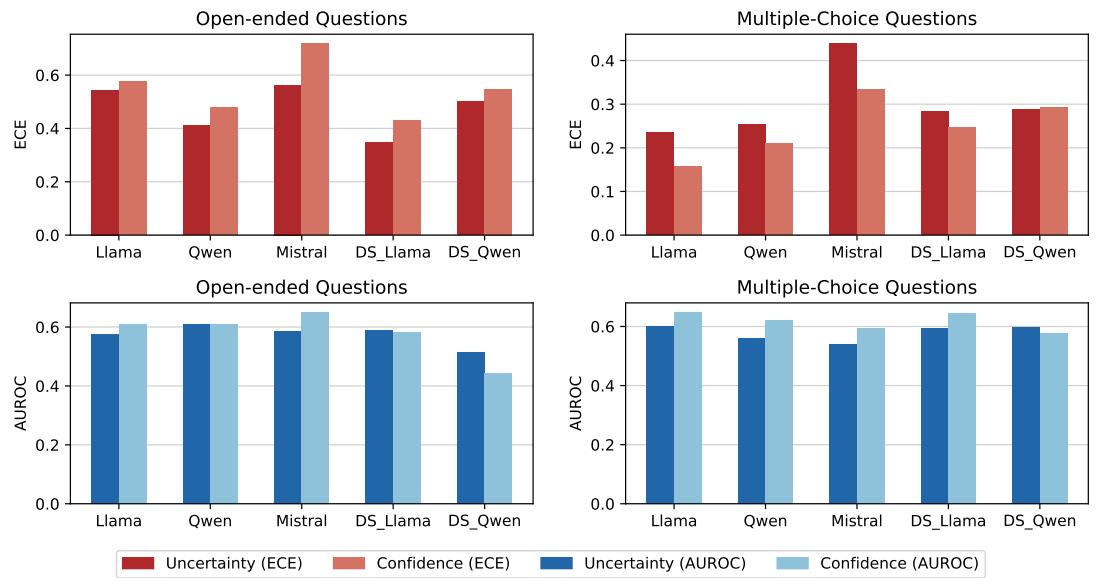

图 1 : 在开放式和多项选择任务中,平均期望校准误差 (ECE ↓) 与AUROC (↑) 。不确定性在开放式任务中表现更优,而置信度在多项选择任务中占优。

在开放式任务 (如TriviaQA或MATH) 中,不确定性带来更好的校准效果。由于可能答案空间巨大,对问题的不确定性自然与模型表现相关。

而在多项选择任务中, 置信度的表达更有效。LLM可以排除其他选项,对唯一选择表达更准确的确定性。

核心要点:

- 对于开放式推理——评判不确定性。

- 对于结构化的多项选择题——评判置信度。

如何评判: 自我评判 vs. CritiCal

在厘清了评判什么后,研究者接着探究如何评判。模型能否有效地自我评判,还是需要外部指导?

他们比较了两种策略:

1. 自我评判 (Self‑Critique) ——通过提示反思

在自我评判中,模型通过多轮提示重新审视自己的答案。每一轮要求LLM重新考虑模糊点和逻辑漏洞,再更新其置信度评分。

然而,结果在不同模型和任务间不尽相同。

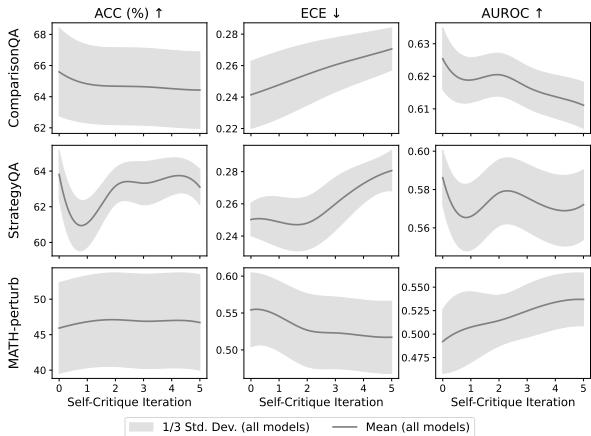

图 2 : 多轮自我评判结果。准确率略降,而校准误差 (ECE) 往往随着轮次数增加而恶化。

自我评判几乎没有提升校准效果,反而有时会使其更糟。在事实推理任务中,ECE上升,表明置信度偏离正确性更远。

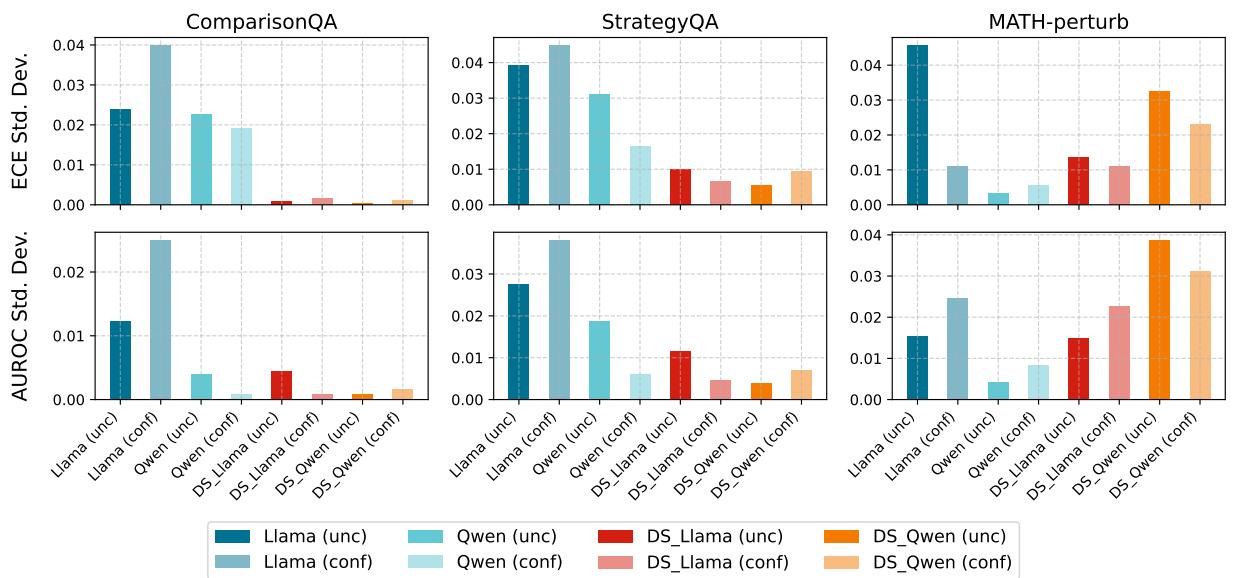

图 3 : 6轮自我评判的变化趋势。大型推理模型 (LRM,暖色) 较为稳定,但总体增益仍然有限。

模型之间呈现不同,甚至相反的趋势。

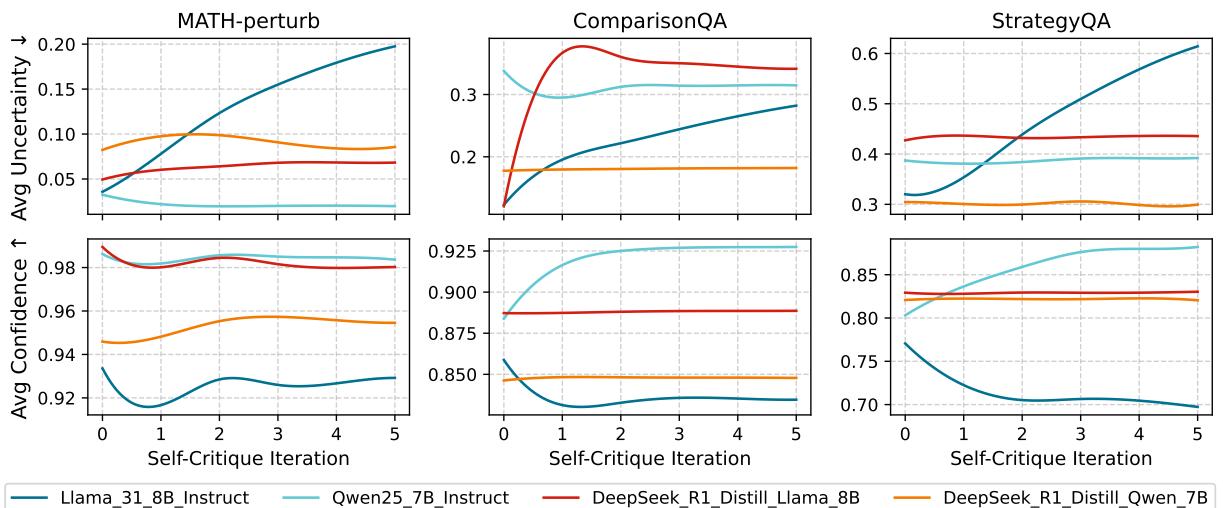

图 4 : 自我评判过程中的平均不确定性与置信度变化。Llama变得更不确定;Qwen则更自信——揭示了不一致的偏差。

总而言之: 自我评判缺乏可靠改进所需的客观参照。没有外部反馈,模型倾向于强化自身偏见,而非纠正它们。

2. CritiCal —— 基于监督评判的校准

为克服上述问题,研究者提出了CritiCal方法,这是一种监督式微调 (SFT) 方案,借助外部评判学习置信度校准。

图 5 : 传统校准与CritiCal的对比。CritiCal以解释性评判取代数值标签,引导模型推理置信度的合理性。

流程如下:

- 学生回答生成: 一个较小的“学生”模型回答问题并输出语言化置信度分数。

- 教师评判生成: 一个较大的“教师”模型——GPT‑4o——对学生回答和正确答案进行审查,生成自然语言评判以评价学生的置信度。

- 基于评判微调: 学生模型被微调为生成类似的评判输出。

学生模型不再去记忆具体的置信度数值,而是学习将推理强度与正确性关联到置信度等级——掌握如何判断自身推理的充分性。

实验: 验证CritiCal

研究作者将CritiCal与多项基线方法进行对比测试:

- 普通提示

- 自我评判

- SFT‑Hard (使用极端0%/100%置信度标签训练)

- SFT‑Soft (使用较柔性的20%/80%标签训练)

所有测试涵盖了事实类、推理类及数学密集型任务的数据集。

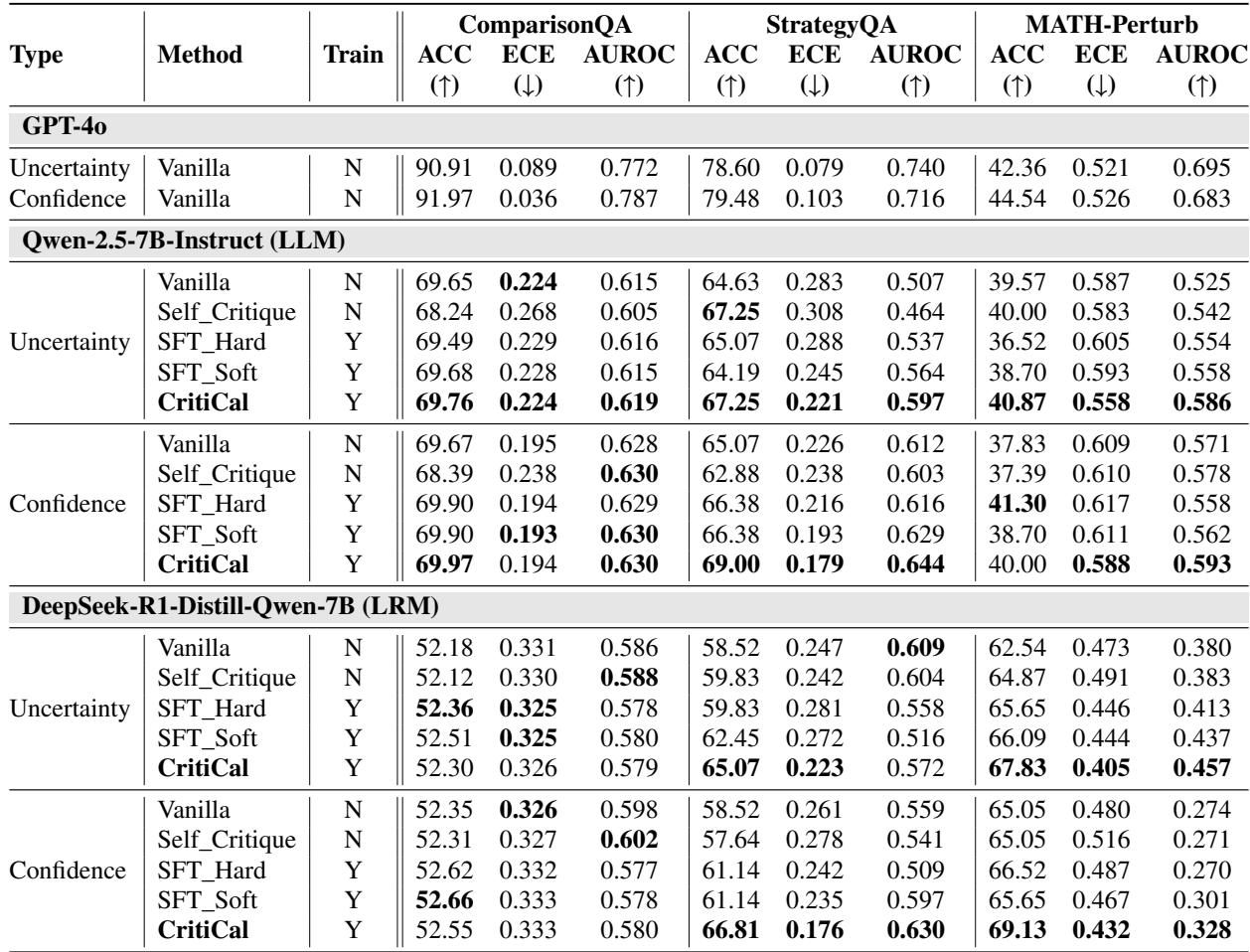

分布内准确性

在复杂推理任务中,CritiCal始终实现最低的校准误差 (ECE) 和最高的AUROC。

表 1 : 三个基准测试的分布内表现。CritiCal在StrategyQA和MATH‑Perturb上表现最佳。

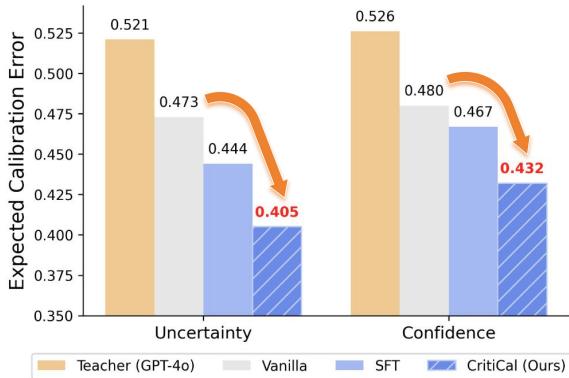

最令人兴奋的发现是: 通过CritiCal训练的学生模型有时竟能超越它的老师 。

图 6 : MATH‑Perturb结果。CritiCal (深蓝) 优于普通模型、SFT,甚至超越其教师GPT‑4o (橙色) 。

这一惊人的结果表明,基于评判的学习不仅能传递技能,还能传递判断质量。学生模型内化了校准原则,使其在校准准确性上超过了教师。

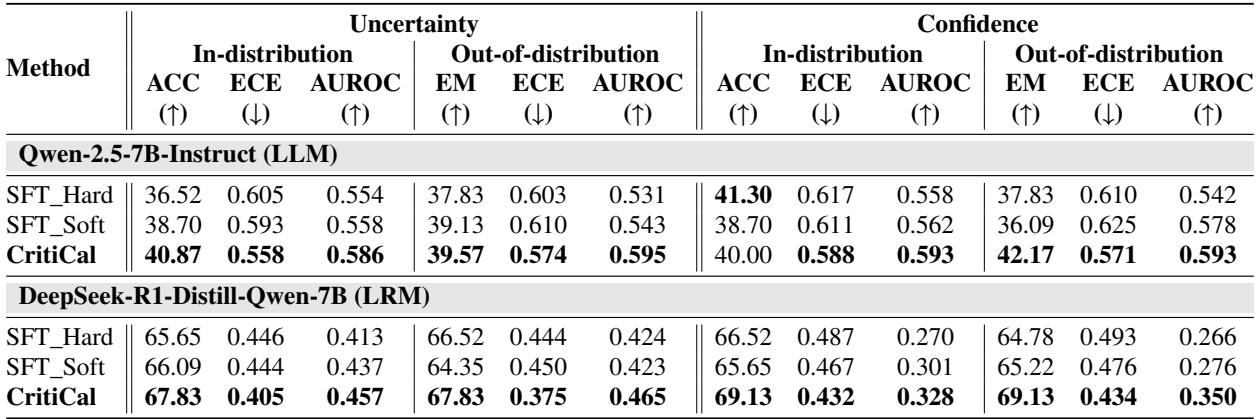

分布外泛化能力

研究进一步检验CritiCal的跨任务迁移能力: 在多跳推理 (StrategyQA) 上训练的模型,被用于测试数学推理 (MATH‑Perturb) 任务。

表 2 : 从StrategyQA到MATH‑Perturb的迁移结果。CritiCal保持甚至提升了校准表现,而标准SFT性能下滑。

当硬标签和软标签SFT在未见任务上均失败时,CritiCal却表现改善。评判帮助模型学习到可泛化的推理信号,而非特定数据集模式。

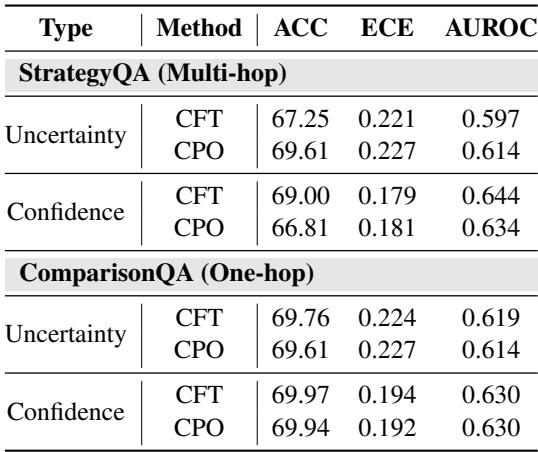

哪种训练方式更好: SFT还是DPO?

研究团队还比较了直接偏好优化 (DPO) ——一种强化式微调方法——与SFT在CritiCal训练中的表现。

表 3 : SFT与DPO在CritiCal中的对比。结果几乎相同;SFT因效率更高而更受青睐。

DPO取得相近效果,但计算成本显著增大。因此, SFT是CritiCal的高效且充分的训练方案 。

CritiCal的意义

CritiCal不仅仅在调整置信度分数,它让模型学会判断自身确定性的合理性。这种转变令校准更具可解释性、稳定性与可迁移性。

本研究揭示的关键洞见包括:

- 不同任务需要针对性评判目标。 开放式推理任务校准不确定性 ; 多项选择任务校准置信度 。

- 仅靠自我反思远远不够。 缺乏外部评判时,模型容易强化内部偏差。

- 评判促进结构化的自我认知。 通过学习教师评判,学生模型获得语境化的推理强度理解。

- 经评判训练的模型具备泛化能力,甚至能够超越教师。 设计良好的评判信号能胜过直接数值优化。

结论: 迈向具备自我认知的人工智能

CritiCal框架代表着迈向可靠AI系统的重要一步。它将校准从单纯数字猜测转变为语言推理过程——帮助模型理解逻辑、正确性与确定性之间的关系。

一个能意识到自身不确定性,并能解释原因的LLM,远比自信陈述错误的模型更有用。随着基于评判的训练逐渐普及,LLM将从“能说会道”者转变为值得信赖的协作者 , 能够在必要时提醒用户谨慎判断其输出。

CritiCal提醒我们,在AI安全领域, 自我认知与智能同等重要 。

](https://deep-paper.org/en/paper/2510.24505/images/cover.png)