一刀切行不通: 利用 AutoGFM 定制图基础模型

在自然语言处理 (NLP) 领域,像 GPT-4 这样的基础模型已经彻底改变了行业格局,它们提供了一个能够处理多种任务的统一模型。图机器学习社区也一直在竞相实现类似的壮举: 创建图基础模型 (Graph Foundation Models, GFMs) 。 这些模型旨在跨越不同的领域——从社交网络到分子结构——共享知识,使得单个模型就能执行节点分类、链路预测和图分类任务。

然而,这其中存在一个巨大的障碍。与文本相对一致的结构格式 (标记序列) 不同,图的差异巨大。引用网络看起来与蛋白质分子毫无相似之处。目前的 GFMs 通常依赖于一种手工设计的、固定的图神经网络 (GNN) 架构 (如标准的 GraphSAGE 骨干网络) 来处理所有输入。

这就导致了一个问题: 架构不一致性 (Architecture Inconsistency) 。 社交网络的最佳神经架构很少是分子图的最佳架构。如果强行对所有数据使用同一种架构,我们就不可避免地要接受次优的性能。

在这篇文章中,我们将深入探讨 AutoGFM (自动化图基础模型) ,这是在 ICML 2025 上提出的一项新颖方法。该论文提出了一种为每个特定图数据集自动定制神经架构的方法,将基础模型的强大功能与神经架构搜索 (GNAS) 的精确性结合在了一起。

核心问题: 架构不一致性

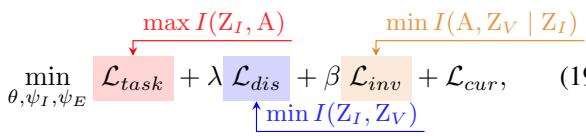

为了理解为什么需要 AutoGFM,我们首先需要将问题可视化。研究人员进行了一项初步研究,在不同的数据集上测试了各种流行的 GNN 架构 (GCN、GAT、GraphSAGE 等) 。

如图 1 所示,没有唯一的“赢家”。

- GCN (图卷积网络) 在 Arxiv 数据集 (深蓝色) 上表现出色,但在 WikiCS 数据集上表现挣扎。

- GraphSAGE 在 Cora 上很强,但在其他地方较弱。

如果你仅使用 GCN 作为骨干来构建图基础模型,你就自动限制了在那些更倾向于注意力机制 (GAT) 的任务上的性能上限。这种现象就是作者所说的架构不一致性 。

现有的图神经架构搜索 (GNAS) 方法试图找到“最好”的架构,但它们通常是搜索一个能最小化所有训练数据总损失的单一架构。当这些数据来自截然不同的领域时 (基础模型通常如此) ,搜索算法就会面临优化冲突 。 它试图满足分歧巨大的需求,最终只能找到一个对谁都不太好的“折衷”架构。

解决方案: AutoGFM

研究人员提出了 AutoGFM , 这是一个不将架构视为固定的全局超参数,而是根据输入图的特征进行动态预测的框架。

其核心思想是学习一个映射函数 \(\pi\),它接收一个图 \(\mathcal{G}\) 并输出一个定制的架构 \(\mathcal{A}\)。

高层框架

AutoGFM 框架由三个主要组件组成,旨在处理多样化图数据的复杂性:

- 解耦对比图编码器 (Disentangled Contrastive Graph Encoder) : 为了弄清楚图需要什么架构,我们需要先了解图的属性。该编码器将图特征分为不变模式 (Invariant patterns) (决定架构的结构属性) 和变体模式 (Variant patterns) (不应影响架构选择的噪声或特定任务数据) 。

- 不变性引导的架构定制 (Invariant-Guided Architecture Customization) : 一个“超网络 (Super-Network) ”,利用不变模式为特定输入动态选择最佳的 GNN 操作 (层) 。

- 课程架构定制 (Curriculum Architecture Customization) : 一种训练策略,防止简单的在早期主导搜索过程。

让我们逐步拆解这些组件。

第一步: 解耦对比图编码器

我们如何决定哪种架构最适合给定的图?作者认为,我们需要从“不变性”的角度来观察图的内在属性。

他们假设图数据由两部分组成:

- 不变模式 (\(Z_I\)): 这些是与最佳架构相关联的稳定特征。例如,一个图是同配的 (邻居相似) 还是异配的,这就是一种强烈暗示我们应该使用 GCN 还是其他算子的不变模式。

- 变体模式 (\(Z_V\)): 这些是与特定数据实例相关,但与架构选择无关或属于噪声的特征。

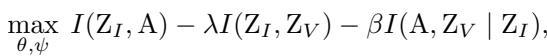

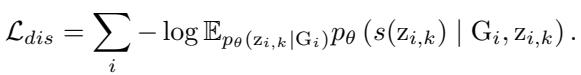

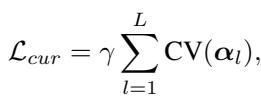

目标是最大化不变模式 \(Z_I\) 与架构 \(A\) 之间的互信息,同时最小化变体模式 \(Z_V\) 的干扰。优化目标如下所示:

在这里,模型试图:

- 最大化 \(Z_I\) 和架构 \(A\) 之间的联系。

- 最小化 \(Z_I\) 和 \(Z_V\) 之间的重叠 (解耦) 。

- 确保在给定 \(Z_I\) 的情况下,架构 \(A\) 独立于 \(Z_V\)。

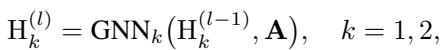

编码器架构

为了实现这种分离,模型使用了两个独立的 GNN 通道。给定一个子图 (定义为“感兴趣节点”或 NOI-graph) ,编码器通过两个并行流对其进行处理:

随后是一个多层感知机 (MLP) 和一个池化 (Readout) 函数,以获得图级表示:

对比学习

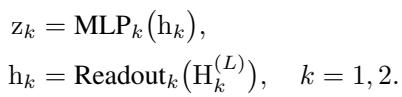

为了强制这些表示真正捕捉到有意义的差异,AutoGFM 使用了对比学习 。 这个想法很简单: 来自同一领域/任务的图可能共享相似的架构需求 (相似的 \(Z_I\)) ,而来自不同领域的图应该在嵌入空间中被推开。

模型使用了一个损失函数,将不变表示 \(z_{i,k}\) 拉近其聚类的“原型” \(p_k\),同时将其推离其他原型:

此外,为了确保不变模式 (\(Z_I\)) 与变体模式 (\(Z_V\)) 截然不同,模型采用了一个判别任务。这迫使编码器识别出 \(Z_I\) 和 \(Z_V\) 代表图的不同方面。

第二步: 不变性引导的架构定制

一旦我们有了不变表示 \(Z_I\),我们需要将其转化为实际的神经网络架构。AutoGFM 使用了一个权重共享超网络 (Weight-Sharing Super-Network) 。

想象一个巨大的 GNN 层,它同时包含所有可能的操作——GCN、GAT、GIN 等。该层的输出是所有这些操作的加权和。

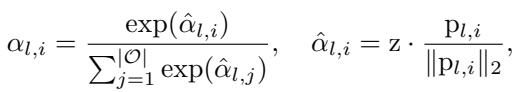

这里,\(\alpha_{l,i}\) 代表在第 \(l\) 层选择操作 \(i\) 的概率 (或权重) 。

预测器

AutoGFM 不是像标准 NAS 那样为整个数据集学习一个固定的 \(\alpha\),而是使用一个预测器 (\(\psi_I\)),它接收不变图表示 \(z\) 并输出权重 \(\alpha\)。

如果图表示 \(z\) 接近特定操作 (比如 GAT) 的可学习原型 \(p_{l,i}\),那么 GAT 的权重就会增加。这有效地将图“路由”到了正确的神经架构。

屏蔽变体模式

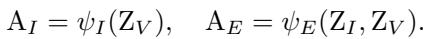

这里的一个关键创新是防止“变体” (噪声) 模式干扰架构预测。作者提出了一种利用辅助预测器 (\(\psi_E\)) 的巧妙训练技巧。

他们生成两个架构预测:

- \(A_I\): 仅使用不变模式 \(Z_I\) 进行预测。

- \(A_E\): 使用 \(Z_I\) 和变体模式 \(Z_V\) 的融合进行预测。

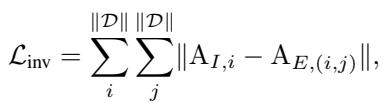

目标是使 \(A_I\) 和 \(A_E\) 相同。如果加入变体模式 (\(Z_V\)) 后架构预测发生了变化,这意味着我们的预测器受到了噪声的影响。通过最小化这两个预测之间的差异,模型学会了忽略 \(Z_V\) 并仅依赖 \(Z_I\)。

第三步: 课程架构定制

训练基础模型涉及多样化的数据集。有些“容易” (几乎可以用任何 GNN 拟合) ,有些则“困难”。

如果我们天真地进行训练,超网络很可能会在训练早期收敛到对容易、占主导地位的数据集有效的操作上。更困难、更复杂的数据集所需的操作可能会因为缺乏梯度而永远无法被学习到。这就是数据主导 (Data Domination) 现象。

为了解决这个问题,AutoGFM 引入了课程 (Curriculum) 机制。它鼓励在训练的早期阶段架构选择具有多样性 。

它计算选定操作在不同数据集上的变异系数 (CV) 。

通过将这一项添加到损失函数中,如果模型为所有人选择相同的操作,就会受到惩罚。随着训练的进行 (由步调参数 \(\gamma\) 控制) ,这种惩罚会减少,允许模型在必要时收敛到最佳 (可能相似) 的架构。但这最初的“强制多样性”确保了所有操作都有公平的学习机会。

最终目标

完整的训练目标结合了任务损失 (分类准确率) 、解耦损失 (分离 \(Z_I\) 和 \(Z_V\)) 、不变性损失 (预测器之间的一致性) 和课程损失:

实验与结果

这种复杂的机制真的值得吗?作者在各种数据集上测试了 AutoGFM,包括引用网络 (Cora, PubMed) 、知识图谱 (WN18RR) 和分子图 (HIV, PCBA) 。

与基线对比

AutoGFM 与以下方法进行了对比:

- 普通 GNN: 标准 GCN, GAT, GIN。

- 自监督方法: GraphMAE, BGRL。

- 其他 GFMs: OFA, GFT。

- 现有 NAS: DARTS, GraphNAS。

下方的 表 1 显示了结果 (准确率) 。请注意,AutoGFM (底部标记为“Ours”) 在几乎所有数据集上都始终取得了最高性能 (加粗显示) 。

至关重要的是,请注意与 DARTS 和 GraphNAS 的比较。这些是传统的神经架构搜索方法。它们的性能通常比简单地选择一个好的手工 GNN (如 GraphSAGE) 还要差。这证明了作者的假设: 由于优化冲突,传统 NAS 在多领域基础模型设置中表现挣扎。AutoGFM 解决了这个问题。

少样本学习

基础模型的承诺之一是对数据很少的新任务的适应能力 (少样本学习) 。研究人员在只有极少样本 (1-shot, 3-shot, 5-shot) 的未见类别上对模型进行了微调。

AutoGFM 显著优于基线 (表 2) ,表明即使在标记数据稀缺的情况下,其生成的定制架构也是非常有效的。

它真的定制了架构吗?

最迷人的结果是可视化模型构建了什么。它真的量身定制了架构吗?

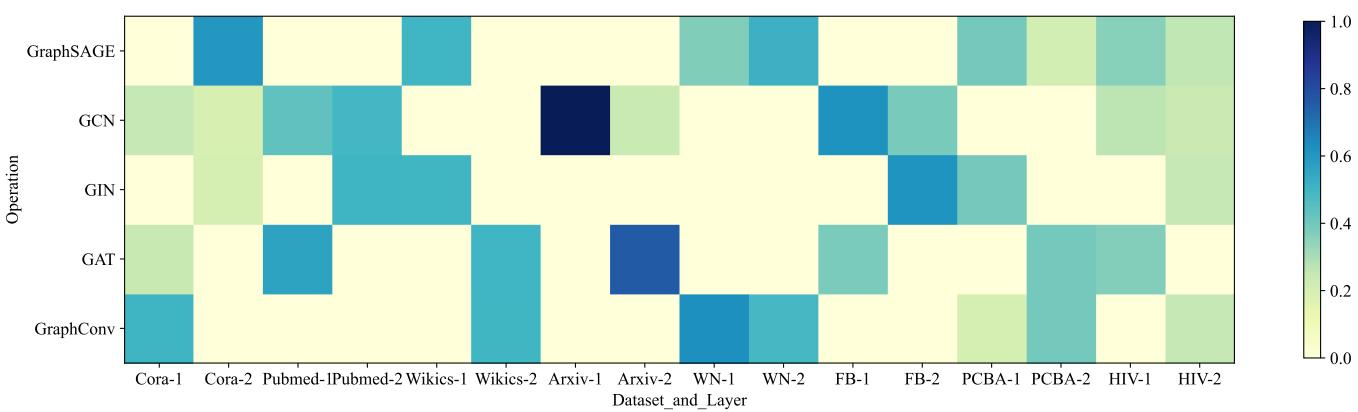

图 4 显示了不同数据集在不同层所选操作权重的热力图。

- 观察 1: 不同的数据集偏好不同的操作。 Cora (前两列) 显示出对 GraphConv 和 GraphSAGE 的强烈偏好。 PubMed (接下来的两列) 避免了这些,偏好不同的组合。

- 观察 2: 层多样性。即使在同一个数据集中,第 1 层和第 2 层也经常使用不同的操作。例如, Arxiv 可能在第一层使用 GCN,在第二层使用 GAT。

这证实了 AutoGFM 不仅仅是在学习一个通用的“平均”架构;它正在根据输入图的特定拓扑结构和特征,积极地定制神经网络结构。

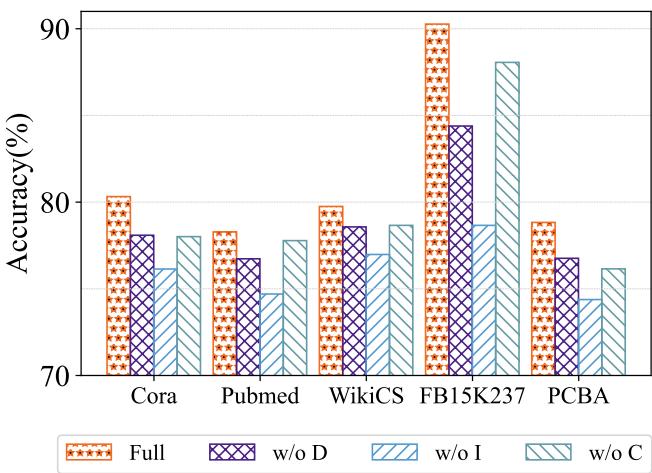

消融研究

最后,为了证明每个组件都很重要,研究人员逐一移除了它们:

- w/o D: 移除解耦编码器。

- w/o I: 移除不变性引导预测器。

- w/o C: 移除课程约束。

如图 3 所示,“Full” (完整) 模型是带有星星的橙色条。在几乎所有情况下,移除一个组件都会导致性能下降。移除不变性模块 (w/o I) 导致了显著的下降,这凸显了在不分离噪声和不变信号的情况下简单地搜索架构会导致泛化能力差。

结论与启示

AutoGFM 代表了图人工智能领域向前迈出的重要一步。它解决了“基础模型”目标 (一个模型处理所有任务) 与“图学习”现实 (每个图都是独特的) 之间内在的紧张关系。

通过利用解耦编码器来识别结构需求,并利用可定制的超网络 , AutoGFM 允许单个模型根据它面对的是社交网络还是化合物,从根本上重塑自己——形象地说,就是换一套行头。

对于学生和研究人员来说,这篇论文强调了一个关键教训: 适应性是关键。 随着我们要构建更大、更通用的模型,根据输入上下文动态调整内部处理机制的能力可能会成为一项标准要求,推动我们超越静态神经架构的时代。

](https://deep-paper.org/en/paper/579_autogfm_automated_graph_fo-1853/images/cover.png)